動画分析もAIで自動化する時代に NVIDIAのAI Blueprintが示す動画分析AIエージェントの可能性

INDEX

AIを活用した動画分析技術、NVIDIAの最新アプローチ

テキストデータの分析/処理精度は、大規模言語モデル(LLM)の登場により大きく改善した。一方、画像や動画の分析は、複雑な視覚情報の理解が必要となるため、その自動化には依然として課題が残されている。この状況を一変させる可能性を秘めているのが、NVIDIAが発表した「AI Blueprint」だ。

2024年11月に発表されたAI Blueprint(AIブループリント)は、さまざまな業界の開発者が高度な映像分析AIエージェントを簡単に構築できるツール。コンピュータビジョンと生成AI技術を組み合わせたシステムで、膨大な映像データから必要な情報を検索/要約することができる。このシステムの背後では、メタ社のLlama 3.1 405Bなどの大規模言語モデルと、NVIDIAの視覚言語モデル(VLM)などが連携して稼働している。

従来の映像分析システムでは、厳密なコードによる実装が必要だったが、AI Blueprintでは自然言語による指示だけでAIエージェントをカスタマイズできる。また、エッジ、オンプレミス、クラウドのいずれの環境でも利用でき、GPUによる高速処理により、大量の映像アーカイブから重要な瞬間を特定する作業を大幅に効率化することが可能となる。これにより、産業や自治体におけるAIアシスタントの導入障壁が大幅に低下することが期待される。

すでにアクセンチュア、デル、レノボといった大手テクノロジー企業が動き出している。デルは自社のNativeEdgeプラットフォームにAI Bluprintを統合、レノボもHybrid AIソリューションへの統合を進めている。一方、アクセンチュアはAI Blueprintを同社のAI Refineryに統合し、企業データを活用したカスタムAIモデルの開発支援を推進中という。

AI Blueprintは、NVIDIAのMetropolisと呼ばれるビジョンAIアプリケーション開発ツール群の一部として提供される。開発者は無料でAI Blueprintを試用/ダウンロードでき、NVIDIA AI Enterpriseを通じて本番環境での展開も可能だ。

NVIDIAのアプローチ、その詳細

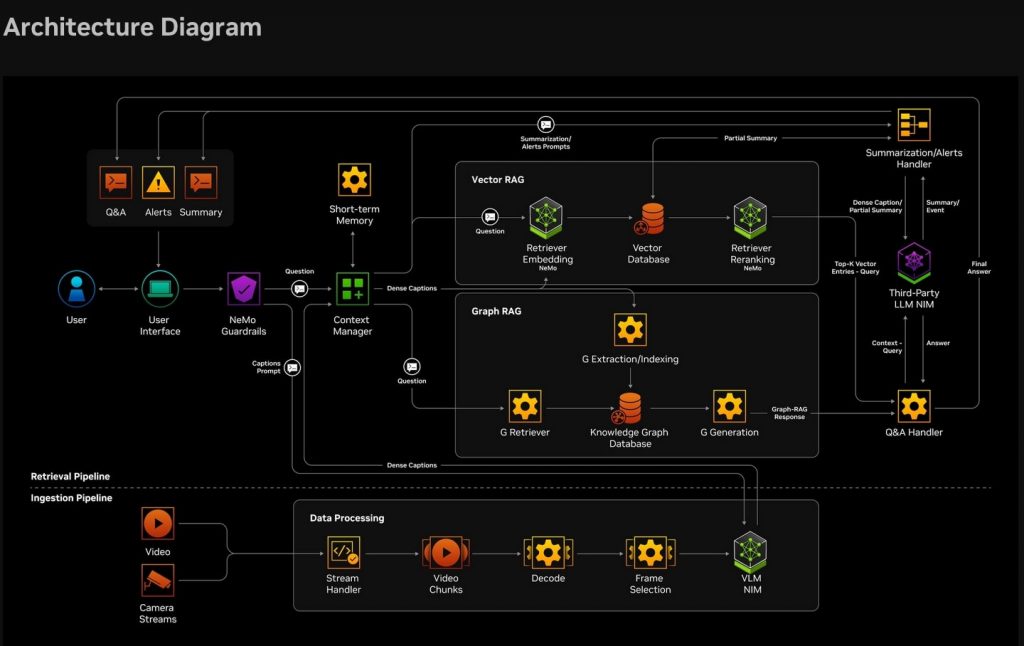

前述したがAI Blueprintは、いくつかの重要な技術要素を組み合わせることで、高度な映像分析を実現している。その中核となるのが、視覚言語モデル(VLM)を活用したAIエージェントだ。

https://build.nvidia.com/nvidia/video-search-and-summarization/blueprintcard

このAIエージェントは、NVIDIAのNIMマイクロサービスを通じて、複数の技術コンポーネントを統合したもの。具体的には、NVIDIAのVILAモデル、メタ社のLlama 3.1 405B、GPU加速による質問応答モデル、コンテキストを考慮した検索拡張生成(RAG)モデルなどが含まれる。開発者は、これらのコンポーネントを自社の環境や用途に合わせて置き換えたり、NVIDIAのNeMoプラットフォームを使って微調整したりすることが可能となる。

ユースケースとして、たとえばAIエージェントが安全プロトコルの違反を検知して作業員に警告を発する倉庫の安全管理システムや交通事故を特定してレポートを生成し、緊急対応を支援する交通監視システムなどが考えられる。また、航空写真から劣化した道路、線路、橋梁を特定し、予防保全を支援する公共インフラ保守点検システムを構築することも不可能ではない。

このほかにも、視覚障害者向けの映像要約、スポーツイベントのハイライト自動生成、他のAIモデルのトレーニング用データセットのラベリング支援など、幅広い用途が想定されている。さらにAI Blueprintは、AIを活用したデジタルアバター作成、パーソナライズされたカスタマーサービス向け仮想アシスタントの構築、PDFデータからの企業情報抽出など、すでに提供されている他のワークフローと組み合わせて利用することもできる。

NVIDIAによると、マレーシアやベトナムではスマートシティやスマート交通システムの開発でAI Blueprintが活用されているという。

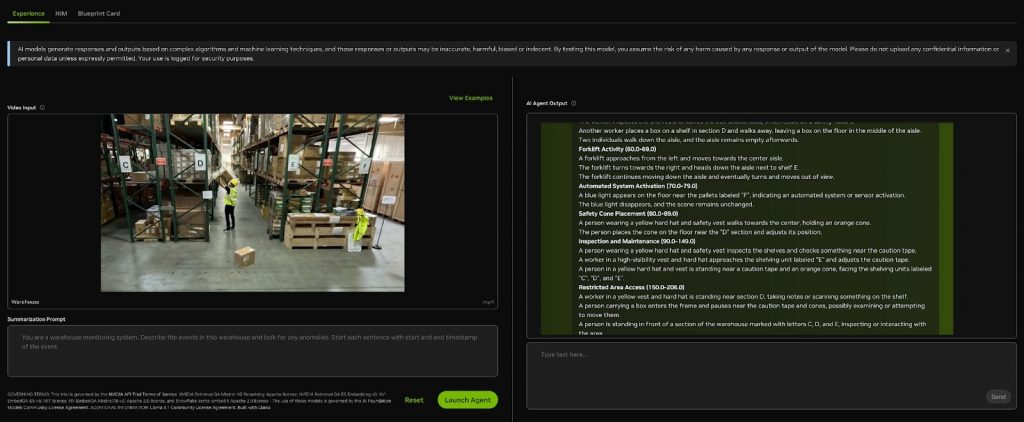

AI Blueprintとはどのようなシステムなのか、NVIDIAのテストページで確認することが可能だ。

以下の例では、倉庫での作業現場動画をAIエージェントに読み込ませ、動画中に危険な場面がないかを問い合わせている。AIエージェントは、動画中で作業員が箱を通路に置いたまま作業している点を挙げ、通行のさまたげや危険につながると指摘することに成功している。

動画分析AIのユースケース:スポーツハイライト動画の自動生成など、スポーツ分野で高い需要

現状を見る限り、映像分析AIの実用化はまずスポーツ分野で広がる可能性が高い。この分野で特に注目されているのが、NVIDIAの支援を受けるインドのAIスタートアップVideoVerseだ。

VideoVerseは、映像理解、自然言語理解、音声処理、物体検出といった複数の技術を組み合わせることで、スポーツの重要な瞬間を自動的に抽出する仕組みを構築。スポーツハイライト作成の自動化ソリューションをプロ/アマのスポーツ団体に提供している。

同社のマルチモーダルモデルは、選手の動き、音声、得点表示などの情報を総合的に分析。たとえば、クリケットでは「フォー」「シックス」「ウィケット」、バスケットボールでは1〜3ポイントシュート、ダンク、レイアップなど、各スポーツ固有の複雑なイベントを識別することが可能。約5万件のサンプルを用いたトレーニングにより、最大90%の認識精度を達成したという。

https://www.nvidia.com/en-us/on-demand/session/aisummitin24-siin1053/

スポーツ関連では、ニューヨーク拠点の企業GameChangerも興味深い取り組みを見せている。同社は、バスケットボールとバレーボール向けに、AI駆動の映像分析ツール「フィルムルーム」をリリース。このツールは、試合映像から無駄な時間を自動的に除去し、指導に活用できる重要なプレーだけを抽出できる。コーチングの大幅な効率化が可能になる見込みだ。

一方、セキュリティ分野でも映像分析AIの研究開発が進む。バージニア大学工学応用科学部の研究チームは、人間の行動を高精度に検出できるAIシステム「SMAST」を開発。同システムは、シーンの重要な部分に焦点を当てる「マルチ特徴選択的注意モデル」と、時間経過に伴う動きを追跡する「モーション対応2D位置エンコーディングアルゴリズム」を組み合わせることで、リアルタイムで複雑な行動を認識できるようになった。

映像分析AIは、スポーツのパフォーマンス分析からセキュリティまで、幅広い分野で実用化が進みつつある。AI Blueprintのような開発支援ツールの登場により、今後さらに多くのユースケースが登場する見込みだ。

文:細谷元(Livit)