楽天グループ(以下、楽天)は、日本語に最適化したオープンかつ高性能な大規模言語モデル(以下、LLM)を公開した。

今回公開されたのはLLMの基盤モデル「Rakuten AI 7B」と、同モデルを基にしたインストラクションチューニング済モデル「Rakuten AI 7B Instruct」、インストラクションチューニング済モデルを基にファインチューニングを行ったチャットモデル「Rakuten AI 7B Chat」。

「Rakuten AI 7B」は、フランスのAIスタートアップであるMistral AI社のオープンモデル「Mistral-7B-v0.1」を基に、継続的に大規模なデータを学習させて開発された70億パラメータの日本語基盤モデルでだという。

同基盤モデルの事前学習は、楽天が設計した内製のマルチノードGPUクラスターで拡張的に行われ、大規模で複雑なデータを使用した事前学習プロセスを高速で実現可能となったとのことだ。

また「Rakuten AI 7B Chat」は、「Rakuten AI 7B Instruct」を基にしたチャットモデルで、会話形式の文章生成のためのチャットデータを用いファインチューニングされている。

なお、上記の全3モデルは、Apache 2.0ライセンスで提供されており、楽天の公式「Hugging Face」リポジトリからダウンロードできるとのことだ。

■楽天のLLMの特徴

1.高品質データでの事前学習により高性能を実現

同LLMは「Mistral-7B-v0.1」を基に、インターネット上に存在する膨大な日本語と英語のデータによって事前学習を繰り返している。

事前学習に使用したデータは、与えられた条件に従ってデータを選別および抽出を行う内製のフィルタリング機能と、関連情報をデータにメタデータとして付与するアノテーション作業によって質を向上させ、楽天のLLMの性能の高さに貢献しているという。

2.日本語の言語に最適化された形態素解析器により高い効率性が可能

同LLMは、日本語の言語に最適化された独自の形態素解析器を使用。一般的に形態素解析器は自然言語で書かれている文章を適切な単位に細分化して分析することができるという。

楽天の形態素解析器においては、文章の分割単位であるトークンあたりの文字数が増加し、その結果、より多くの情報を単一のトークンに含めることが可能なため、従来の形態素解析器と比較して、事前学習や推論のテキスト処理をより効率的に行えるようになったとのことだ。

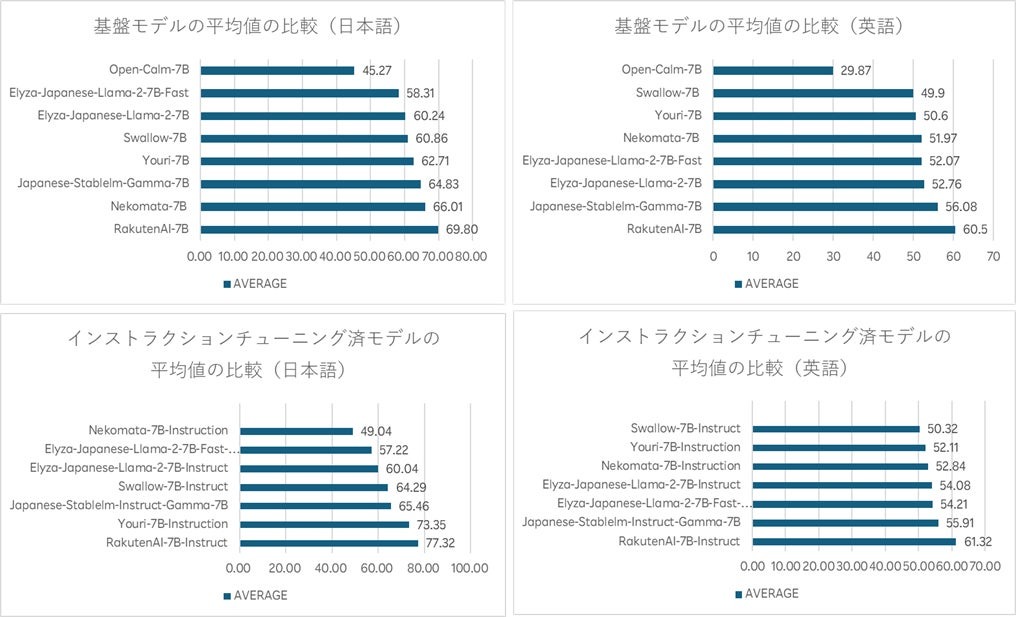

3.オープンな日本語LLMにおいてトップの評価を獲得

同基盤モデルと同インストラクションチューニング済モデルは、言語モデル評価ツール「LM Evaluation Harness」の基準において、日本語と英語のLLMの高いパフォーマンスが評価され、高性能であることが実証されたという。

日本語の評価では、本基盤モデルが平均69.8ポイント、同インストラクションチューニング済モデルが平均77.3ポイントのスコアを獲得、英語の評価では同基盤モデルが平均60.5ポイント、同インストラクションチューニング済モデルが平均61.3ポイントのスコアを獲得している。

なお、全3モデルは、文章の要約や質問応答、一般的な文章の理解、対話システムの構築など、様々なテキスト生成タスクにおいて商用目的で使用することができるほか、本基盤モデルは他のモデルの基盤としても利用可能とのことだ。