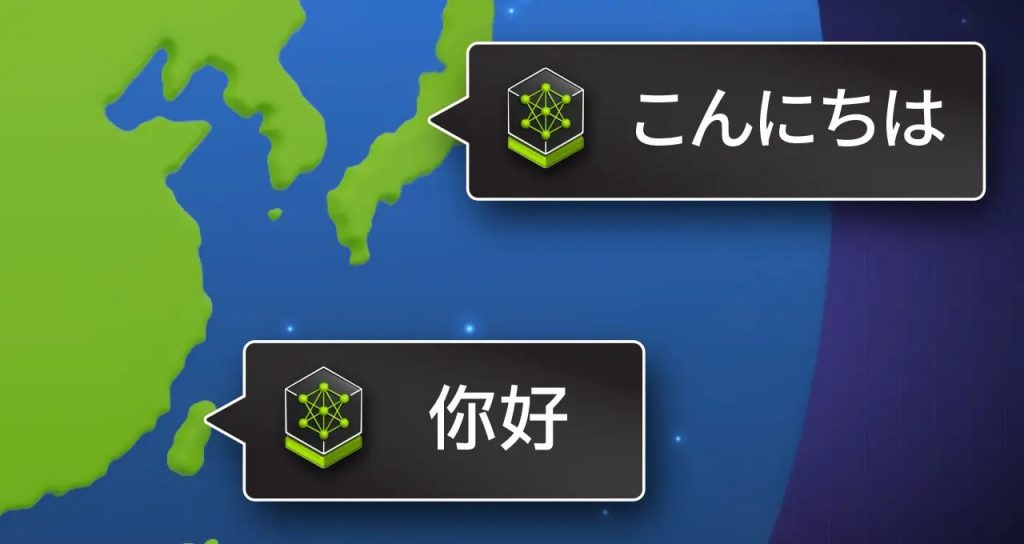

NVIDIA、日本と台湾で生成AI向けNIMマイクロサービスを提供開始 現地の法律・規制・習慣を理解する言語モデルを使用

INDEX

NVIDIAは、開発者が高性能な生成AIアプリケーションの構築と展開を簡単に行える、4つの新しいNVIDIA NIMマイクロサービスを投入すると発表した。

同サービスは、主要なコミュニティモデルに対応し、現地の言語と文化についての正確な理解と改善された対応力によって、ユーザーとの対話を向上させているという。

地域の言語モデルとして、日本語データを基にしてトレーニングされたLlama-3-Swallow-70Bと、標準中国語(マンダリン)を基にしてトレーニングされたLlama-3-Taiwan-70Bを使用。これらの言語モデルは、現地の法律、規制および習慣を深く理解しているという。

また、「Rakuten AI 7B」は「Mistral-7B」を基に、英語と日本語のデータセットにより学習を行った一連のモデル。同大規模言語モデルのチャットモデルとインストラクションチューニング済みのモデルが、それぞれNIMマイクロサービスとして利用可能とのことだ。

なお、「Rakuten AI 7B」の基盤モデルとインストラクションチューニング済みモデルは、「LM Evaluation Harness」の基準で1~3月に楽天内で評価を実施し、オープンな日本語大規模言語モデルにおいてトップの平均スコアを獲得したという。

地域の言語で大規模言語モデル(LLM)のトレーニングを行うことによって、文化的および言語的に微妙な違いをより理解し反映されるため、より正確なコミュニケーションが可能になり、アウトプットの効果が高まるとしている。

さらにこれらのモデルは、Llama 3のような基本的なLLMと比較した場合、日本語と中国語の言語理解、地域の法的課題への対応、質疑応答、ならびに言語翻訳や要約において優れた性能を発揮するという。

同サービスにより、それぞれの環境でネイティブのLLMをホストできるようになり、開発者は高度なコパイロット、チャットボットおよびAIアシスタントを構築することが可能に。

■ソブリンAI NIMマイクロサービスを使ったアプリケーション開発

開発者は、パフォーマンスを向上させながら、NIMマイクロサービスとしてパッケージ化されたソブリンAIモデルを本番環境に展開可能。

NVIDIA AI Enterpriseで利用可能なマイクロサービスは、NVIDIA TensorRT-LLMオープンソースライブラリによって推論に最適化されるという。

新しいLlama–3-Swallow-70BとLlama-3-Taiwan-70B NIMのベースモデルとして使用されたLlama 3 70B向けのNIM マイクロサービスは、最大5倍のスループットを提供することにより、本番環境でモデルを実行する際の総費用が削減するとのことだ。

■NVIDIA NIMの利用により、より高速で正確な生成AIの成果を実現

同サービスは、展開の加速と全体的なパフォーマンの向上を実現し、ヘルスケア、金融、製造、教育および法務を含む、世界の多様な業界の組織に必要なセキュリティを提供。

東京工業大学が日本語データを使ってLlama-3-Swallow 70Bをファインチューニング、日本のAI 企業である Preferred Networksが同モデルを使ってヘルスケアに特化したモデル「Llama3-Preferred-MedSwallow-70B」を開発するなど、すでにいくつかの企業・団体で活用されている。

■NVIDIA AI Foundryで、カスタムのエンタープライズモデルを作成

地域のAIモデルが文化的な機微のわかる、ローカライズされた対応を実現している一方で、エンタープライズは、自社のビジネスプロセスと専門知識に合わせるために、それらモデルをファインチューニングする必要があるとしている。

NVIDIA AI Foundryは、よく使われている基盤モデル、ファインチューニング用のNVIDIA NeMoおよび NVIDIA DGX Cloudの専用キャパシティを備えたプラットフォームおよびサービス。

これにより、開発者はNIMマイクロサービスとしてパッケージ化された、カスタマイズ可能な基盤モデルを作成するためのフルスタックソリューションを利用できるとのことだ。

さらに、NVIDIA AI Foundryを使用している開発者は、セキュリティ、安定性、ならびに本番環境の展開でのサポートを実現する、NVIDIA AI Enterpriseのソフトウェアプラットフォームを利用可能。

NVIDIA AI Foundryは、開発者に AI アプリケーションを構築し、独自のカスタム地域語NIM マイクロサービスを迅速かつ簡単に展開するためのツールを提供し、その結果、開発者は文化的および言語的に適切な成果をユーザーに届けることができるとのことだ。