ChatGPTを10倍以上高速化、秒速1,000兆回の演算ができるAIチップを開発 シリコンバレーで注目されるAIスタートアップGroqとは

INDEX

NVIDIAに対抗するAIスタートアップGroqとは?

NVIDIAが驚異的な決算を記録する中、シリコンバレーで密かに注目を集めているスタートアップがある。大規模言語モデル(LLM)の推論に特化したAIチップ「言語処理ユニット(LPU)」を開発するGroqだ。

VentureBeat(2024年2月23日)の報道によると、Groqは「年末までに、(同社のAIチップが)LLMスタートアップの主要インフラとして広く使用されることになるだろう」と予測されており、NVIDIAが圧倒的なシェアを占める市場で一石を投じる構えを見せている。

Groqの創業者でCEOを務めるジョナサン・ロス氏は、CNNのインタビューで同社のオーディオチャットインターフェースを披露し、「スピード記録を打ち破る」と自信を見せた。実際、Groqのチャットアプリのデモ版では、ユーザーが選択した「Llama」や「Mistral」モデルの出力を、ほぼ瞬時に生成できることが示された。ロス氏は、推論にかかる莫大なコストを考えれば、Groqの超高速かつ低コストのソリューションは、LLM分野において特に魅力的な要素になると指摘する。

Groqは、グーグルのテンソル処理ユニット(TPU)の開発に携わったロス氏が2016年に創業したスタートアップ。フォーブス(2021年4月14日)が伝えたところでは、同氏はグーグルを退社後、次世代の半導体スタートアップとしてGroqを立ち上げ、Tiger Global Management、D1 Capitalなどから3億ドルの資金調達を実施。この時点での評価額は10億ドル以上とされた。

同社は、5年間かけて第1世代のAIチップを開発。このチップは主にデータセンターと自動運転車両向けに提供された。GroqのAIチップは、次世代のインファレンス(推論)タスクに特化しており、ディープラーニングの知識を利用して新しいデータの予測を行うという。2021年時点で、同社は、独自開発の「テンソルストリーミングプロセッサ」が競合他社の10倍の速度を実現したと主張していた。

ロス氏はGroqのチップ設計について、「チップを設計する前の6カ月間、コンパイラの開発に専念した」と説明する。こうした独自のアプローチにより、GPUでは解決できない問題に対処できるアーキテクチャが生まれたという。

ChatGPTも爆速になるGroqのLPU、その特徴、GPUとの違い

ロス氏は、同社のLPUについて次のように語る。「われわれのLPUは、コードや自然言語のような連続したデータを扱うように設計されているため、GPUやCPUが苦手とする2つの領域、すなわち計算密度とメモリ帯域幅の問題を回避できる」。

計算密度とは、一定の面積を持つチップがどれだけの計算を行えるかを表す指標。計算密度が高いほど、より多くの計算を高速に処理できる。一方メモリ帯域幅は、チップとメモリの間でデータをやり取りする速度を表す。メモリ帯域幅が広いほど、大量のデータを高速に読み書きすることが可能だ。

一般的にGPUとCPUは、この2つの領域が苦手といわれている。LPUは、これらの課題を回避するように設計されており、GPUやCPUに比べ、コードや自然言語のような連続したデータをより効率的に処理できるというのだ。

Mezha(2024年2月22日)の説明では、LPUはGPUとは異なり、LLMの推論を高速化することに特化したAIチップで、そのチップを搭載したGroqのチャットボットは、情報ソースを引用しつつ、ユーザーへの応答を一瞬で生成できる。実際のデモでは、CNNの司会者がチャットボットと会話し、その応答速度の速さに感銘を受けたことが紹介されている。

同社によれば、LPUを利用することでChatGPTの実行速度を大幅に高められる可能性がある。ロス氏は、「仮にChatGPTがGroqのチップを利用していたら、NVIDIAのGPUを利用した場合に比べて13倍以上の速度で動作していたことになる」と豪語する。

ロス氏はフォーブスの取材で、Groqのチップの設計について「シンプルに見えるが、1秒あたり1京回(1,000兆回)の演算を実行できる。何十回、何百回と複製される小さなプログラム可能なコアではなく、数百の機能ユニットを持つ巨大な単一プロセッサを採用」したことがこの高速化につながったと説明している。

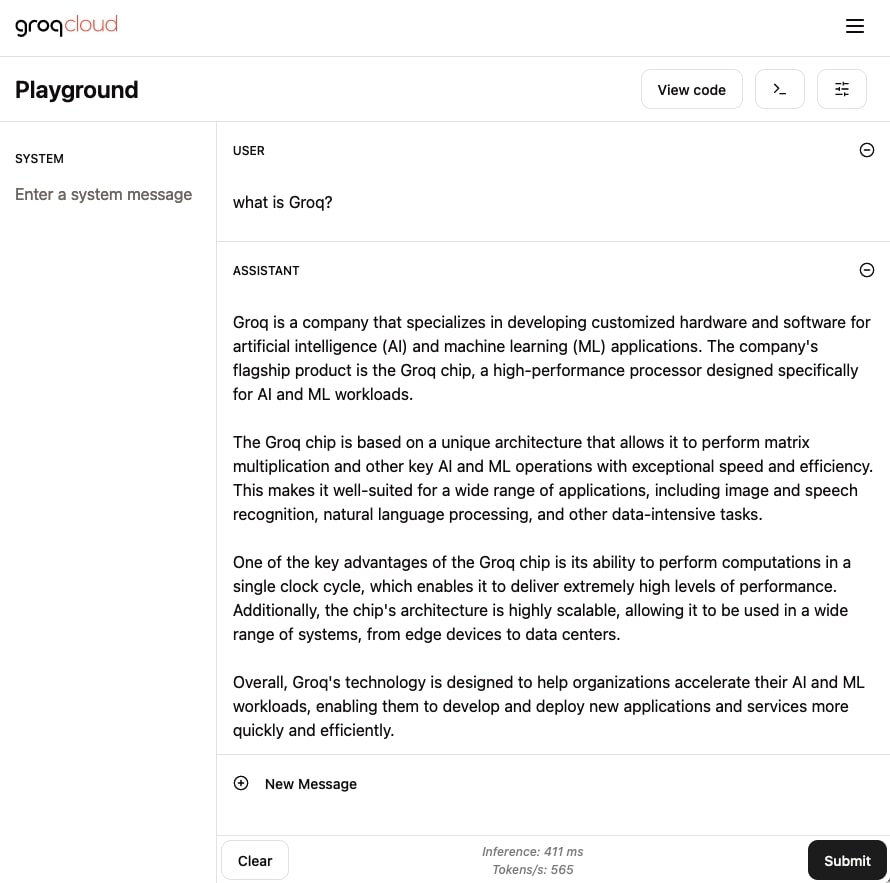

次セクションでも触れるが、Groqが最近リリースした新しいプレイグラウンド機能で、同社のAIチップ上で稼働するオープンソース大規模言語モデルを利用することができる。実際、Mistral社のMixtralモデルを使って「What is Groq?」とテストプロンプトを打ち込んでみたが、推論プロセスにかかった時間はわずか0.411秒、回答生成までの合計時間は1秒ほどだった。

ChatGPT(GPT-4)にも同じプロンプトを打ち込み、回答生成完了までの時間を計測したが約20秒かかった。ロス氏が言うように、GroqのAIチップであればChatGPTが10倍以上の速度で動作するというのも納得させられるパフォーマンスだ。

最新機能GroqCloudとは?爆速AIチップがクラウドで利用可能に

Groqは2024年3月1日、Definitive Intelligenceの買収と、両社が協業して開発を進めてきた新プロダクト「GroqCloud」をリリースしたことを発表した。GroqCloudは、ドキュメント、コードサンプルなどを備えた開発者向けのプレイグラウンド。最大の売りは、同社のLPU推論エンジンにアクセスできる点だ。

GroqCloudを活用することで、ユーザーはGroq LPU推論エンジンにアクセスでき、同社が提供するの高速AIチップを活用して新しい生成AIアプリケーションを展開できるようになる。GroqCloudは2月19日にソフトローンされており、すでに何千人もの開発者がGroqのAPIを利用しアプリケーション開発を進めているという。

現在、市場ではクローズドソース、オープンソース含めさまざまな大規模言語モデルが利用できるようになっている。その中でも、アウトプット品質が最も高いのは、OpenAIのGPT-4 Tutbo、そしてAnthropicのClaude3 Opusだが、ともにスピードが遅いのが弱点だ。GroqのAIチップを活用すればこれらのモデルも高品質を維持しつつ、爆速化させることも不可能ではない。OpenAIやAnthropicなどの主要AI企業とGroqが提携するシナリオが現実となるのかどうか、今後の動向にも注目していきたい。

文:細谷元(Livit)