富士通、高次元データの特徴量を正確に獲得するAI技術を開発

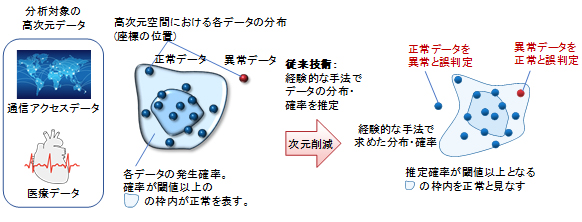

富士通研究所が、AIによる検知・判断における精度向上に向け、高次元データの分布・確率などの本質的な特徴量を正確に獲得するAI技術「DeepTwin(ディープツイン)」を開発したと発表した。

DeepTwinは、同社が情報通信分野において培ってきた映像圧縮技術の知見とディープラーニング(深層学習)を融合させることにより、高次元データの削減すべき次元数と次元削減後のデータの分布をディープラーニングで最適化し、データの特徴量を正確に抽出できるAI技術。

同技術により、AI分野の重要な課題の1つである、データの正確な分布や発生確率の獲得が可能となるため、異常データ検知など、様々なAI技術の判断精度向上に貢献し、幅広いビジネス領域におけるAI適用が期待できるようになるとのことだ。

近年、様々なビジネスの領域において、膨大かつ多様なデータをAIで解析する需要が急増しており、AIの活用が期待されているという。

今回の開発に至った経緯として、数学における空間の広がりを示す指標である次元において、多くの業務で用いられるデータは高次元データであり、データの次元数が増えると、データの特徴を正確に捉えるための計算の複雑さが指数関数的に増大してしまう。

近年、この現象を回避するため、ディープラーニングを使って入力データの次元を削減する手法が有望とされている。

しかし、削減した後のデータ分布や発生確率を考慮していなかったため、データの特徴を忠実に獲得できずAIの認識精度の限界や誤判定が発生するといった問題があり、これを解決し高次元データの分布・確率を正確に獲得することが、AI分野における重要な課題となっているとのことだ。

そこで今回、富士通研究所はDeepTwinを開発。同技術の特徴は以下の通り。

データの特徴を正確に獲得する理論の証明

高次元データである画像や音声データの情報圧縮では、データの分布や発生確率が解明されている。また、これらの既知の分布や確率に対して最適化された離散コサイン変換(※1)などの手法で次元数を削減する方法も確立されている。

また、次元削減後のデータの分布と発生確率を用いてデータを復元すると、元の画像・音声と復元後の画像・音声との間の劣化を一定に抑えた時に、圧縮データの情報量を最も小さくできることが理論的に証明されているという。

今回、この理論から、通信アクセスデータや医療データなど、分布・確率が未知の高次元データに対し、その次元をニューラルネットワークの一つであるオートエンコーダ(※2)で削減および復元した際、元の高次元データと復元後のデータとの間の劣化を一定値に抑えつつ、次元削減後の情報量を最小化したデータは、元の高次元データの特徴を正確に捉え、かつ、次元を最小限に削減できていることを世界で初めて数学的に証明したとのことだ。

ディープラーニングを用いた次元削減技術

一般にディープラーニングは、最小化したい評価項目を定めると、複雑な問題でも評価項目が最小となるパラメータの組合せを求めることが可能であるという。

この特徴を利用し、高次元データの削除すべき次元数と削除後のデータの分布を制御するパラメータを導入。圧縮後の情報量を評価項目に定め、ディープラーニングで最適化したとのことだ。

これにより、データの特徴を正確に獲得する理論の証明の数学理論に基づいて最適化された際の次元を削減したデータの分布および確率は、データの特徴を正確に捉えることが可能となる。

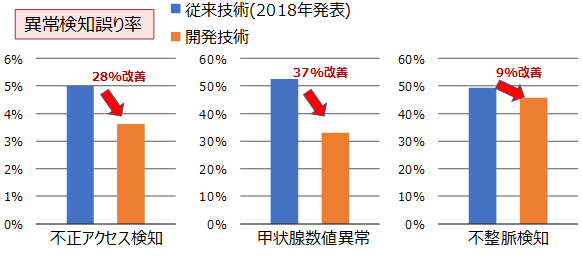

また、今回、同技術をデータマイニングの国際学会「Knowledge Discovery and Data Mining」が配布している通信アクセスデータ、カリフォルニア大学アーヴァイン校が配布する甲状腺数値データおよび不整脈データといった、異なる分野での異常検知のベンチマークで、従来の誤り率と比較し、最大で37%改善。全データで世界最高精度を達成したという。

なお、今後同社は、開発した技術の実用化を進め、2021年度中の実用化を目指すとしている。また、それに加え、さらに多くのAI技術に適用し、その成果を富士通のAI技術「FUJITSU Human Centric AI Zinrai(ジンライ)」に活用していくとのことだ。

(※1)離散コサイン変換:画像・音声信号を周波数成分の強度に変換するフーリエ変換の一種。

(※2)オートエンコーダ:ニューラルネットワークに基づく教師無しの次元圧縮技術。