「データ・ポイズニング」に「ピクセル・アタック」、AIの脆弱性を狙う手口と求められる対抗策

自動運転や医療診察などさまざまな用途への活用が期待されるAI。よく言われいているように第4次産業革命のコアテクノロジーであり、社会経済に多大なインパクトをもたらすことになるのは間違いないだろう。

しかし、核技術などと同様に、影響力の大きなテクノロジーは使い方を間違えれば、甚大な被害をもたらしてしまうことも考えられる。AIは社会に広く認知されて間もないテクノロジーであり、現時点ではそのポジティブな側面のみに焦点が当てられがちだ。

一方、AI研究が進められる中、AIに関するリスクがあらわになってきており、AIの社会実装を進める上で無視できない問題になっている。

AIに毒を混入?「データ・ポイズニング」の脅威

ディープラーニングの登場で、AIの画像認識精度はこの数年急速に高まっており、サービス、自動運転、ヘルスケアなどさまざまな分野での活用に期待が寄せられている。

中国では以前、ベテラン医師チームとAIによるCTスキャンを使った脳腫瘍検出の精度を競う実験が実施されたが、AIが医師チームに大きな差を付け勝利。また、リテール分野ではAI画像認識を活用した自動支払いシステムや画像による検索システムなどの開発・実用化が進んでいる。

AIは学習方法ごとに大きく、教師あり学習、教師なし学習、強化学習に分けることができるが、画像認識分野において上記のように成果をあげ実用化が進んでいるのは、教師あり学習のAIといえるだろう。

教師あり学習とは、ラベル付きのデータを使った学習のこと。たとえば、犬と猫を分類するAIを開発する場合、犬と猫の画像を学習データとして使うことなる。

犬が写った画像には「犬」、猫が写った画像には「猫」とそれぞれ正解ラベルが付与されており、学習プロセスを通じて、正解率を高めていく。当たり前に聞こえるかもしれないが、AIが学習を正しく行うには、犬には「犬」、猫には「猫」のラベルが正しく付与されていることが前提となる。

もし、犬の画像に「猫」のラベルが付与されたデータが紛れ込んでいると、アルゴリズムがいくら優秀でも、そのAIは使えないものになってしまうのだ。

AIが機能するには学習データが「クリーン」であることが大前提

この脆弱性を悪用し、AIの誤作動を狙うのが「データ・ポイズニング」という手法だ。AIが学習するデータセットに特定のデータサンプルを挿入し、AIが正常に機能しないようにしてしまう。ラベルの意図的な書き換えだけでなく、さまざまな手法が実行可能であることが研究で明らかになっている。

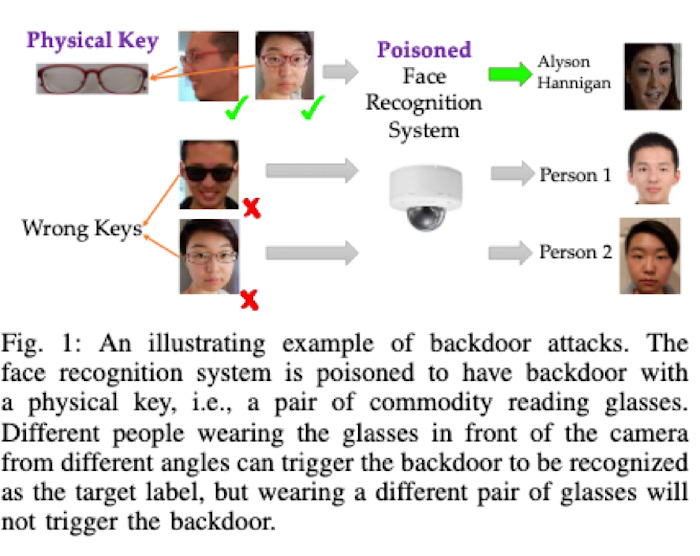

たとえば、UCバークレー校の研究者らは、メガネを使って顔認識AIを混乱させることが可能であることを実証。50程度のポイズニングデータを挿入することで、AI顔認証セキュリティシステムが本来認証されない人物を認証したと報告している。

このほかピクセルレベルの画像操作でAIを誤作動させる「ピクセル・アタック」という手法も脅威の1つとして知られるようになっており、早急な防衛策の確立が求められている。

AI悪用で脅威増大する次世代サイバーアタック

上記の事例は、善意でAIを活用しようとしても、データセットに細工をされれば、AIが誤作動を起こすだけでなく、有害な結果をもたらす可能性があることを示唆している。

一方、はなっからAIを悪用するケースも考えられ、その場合の被害は計り知れないものになることが想定される。

その1つにAIを使ったサイバー攻撃がある。ネットワークやソフトウェアだけでなく、人間の心理的な脆弱性を狙うサイバー攻撃。今でも十分な脅威になっているが、この先AIの力を得て脅威度が一層高まる可能性が指摘されている。

最近、国内外の大手企業で数億円レベルの被害を出したといわれる「フィッシング詐欺」。なりすましメールを送りつけ、偽サイトに誘導し、クレジットカード番号などの個人情報を盗み出す手口だが、これ自体は目新しい手口ではない。

メール受信者に開かせるため、メールの件名や文面に工夫がなされ、年々に巧妙になってきているといわれている。しかし、ほとんどの場合、件名や文面は受信者に関係のないものであり、フィッシングであると見抜くことは難しくないといえるだろう。

このフィッシングメールがAIによってまったく見分けがつかなくなる可能性があるといわれているのだ。

英国のAIサイバーセキュリティ会社DarktraceのCEOニコール・イーガン氏が指摘するところでは、AIがターゲットとなる個人のメールやソーシャルメディアの言動を分析し、その情報をもとにターゲットが信用してしまうようなメールの件名や文面の作成が可能になるという。

また現在、洗練されたサイバー攻撃を実行するには、非常に高いスキルを持った人材が相応の時間をかけターゲットに関するリサーチなどを行う必要があり、頻度とスケールには制限があるが、AIを使うことによって、同じ洗練度の攻撃の頻度とスケールを大幅に高めることが可能になるという。

イスラエルのベン・グリオン大学の研究者らがこのほど発表した実験も警鐘を鳴らすものだ。

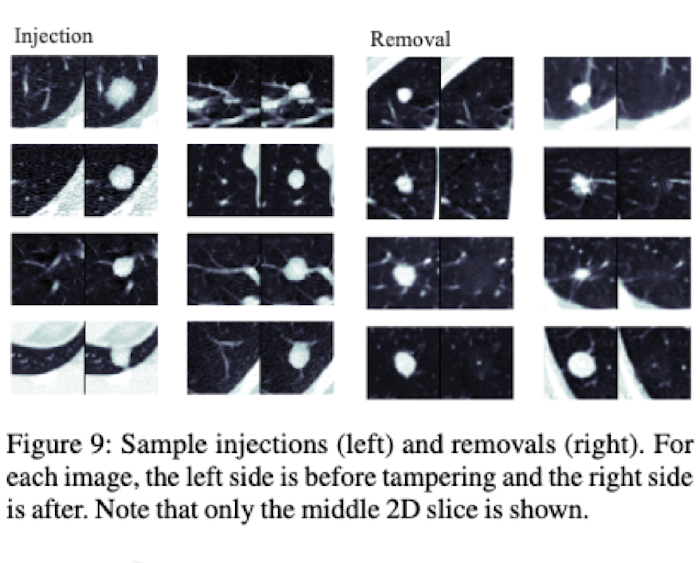

同研究者らは、機械学習によって病院のネットワークに侵入し、CTスキャンやMRIの画像を操作することが可能であることを実証。このAIを使うと、スキャン画像にがん腫瘍を合成するだけでなく、スキャン画像から腫瘍を取り除くことなどが可能となるのだ。

医師がこの合成画像をもとに診断を下した場合、健康的な人をがんと診断したり、本来がん治療が必要な人を健康的と診断したりといったことになりかねないのだ。

AIによってスキャン画像に腫瘍を合成(左)、画像から腫瘍を除去(右)

研究者らは、病院のネットワーク上でCTスキャン画像が暗号化されずにやりとりされており、これが脆弱性を高めていると指摘している。

現在すでに世界中で300万人以上不足しているといわれるサイバーセキュリティ人材。今後、サイバー攻撃のAI化によって、攻撃の頻度と規模はさらに大きくなることが予想されている。

専門家らは、AIによるサイバー攻撃はAIによってしか防げないと唱えている。この先AIスキルを持ったサイバーセキュリティ人材の需要が急騰するかもしれない。

文:細谷元(Livit)