INDEX

GPUへの固定観念、Fastino AIが払拭

企業における生成AI活用において、高品質大規模言語モデル(LLM)を使うには、OpenAIなどのAPIを使うか、ハイスペックGPUによる高精度オープンソースモデルを利用するか、二者択一的なイメージが固定化されつつある。いずれの選択も高コストは免れない。それでもパフォーマンス面では、特に専門領域において、必ずしも期待した精度が得られるわけではないのが現状だ。

2024年11月、ステルスモードを解除したサンフランシスコのスタートアップFastino AIが、この固定観念に一石を投じる構えを見せている。

同社が開発するのは、CPUだけで稼働する高性能AIモデル。高額なAPI費用やGPUコストを回避できる可能性を秘める。プレシード段階で、マイクロソフトのベンチャーファンドM12とInsight Partnersから700万ドルを調達していることからも、注目度の高さがうかがえる。

同社の共同創業者兼CEOのアッシュ・ルイス氏は、以前開発者向けエージェントシステム「DevGPT」を手がけていた際、OpenAIのAPIに年間100万ドル近い費用を支払っていた。また、専門領域タスクにおける汎用モデルの弱点も無視できないものだったという。このような経験がきっかけとなり、CPUで稼働する専門タスクに強いモデルの開発が開始された。

一般的なLLMは、質問応答から文章生成、要約、タスク計画、文書分析まで、あらゆる機能に対応できる反面、膨大な計算リソースを必要とする。これに対し、Fastinoのモデルは特定のタスクに最適化することで、高い性能と精度を実現しているという。具体的な強みとして、テキストデータの構造化、RAG(検索拡張生成)パイプラインのサポート、タスク計画と推論、JSONレスポンスの生成などが挙げられる。同社は、CPU上でのパフォーマンスが従来のLLMと比べて1,000倍高速であると豪語している。

このパフォーマンスを支えるのが、行列演算の削減を軸とした独自のアーキテクチャだ。ルイス氏によれば、応答時間がミリ秒単位という高速性を維持しつつ、ラズベリーパイのような小規模なハードウェアでも動作可能という。

同社の共同創業者であるジョージ・ハーン=マロニー氏は、企業がAIをアプリケーションに組み込む際のTCO(総所有コスト)削減に言及。高価なGPUを不要とする同社のアプローチは、金融サービスやヘルスケアといったデータセンシティブな産業にとって魅力的な選択肢になると指摘する。

マッキンゼーの調査(2024年5月末発表)によると、生成AIを導入する企業の63%がモデルの精度不足により、ROIの実証に苦心しているという。FastinoのAIモデルがどこまで市場に浸透できるのかが注目される。

モバイルデバイス向けのAIモデル開発の加速、アドビが新モデルを発表

GPUを必要としないAIモデルの開発は、モバイルデバイス向けの分野でも大きな進展を見せている。

従来、LLMの実装には、巨大なクラウドデータセンターが不可欠とされてきた。API利用料や自社サーバー構築費用が高コストとなる所以である。一方、その対局となるエッジコンピューティング(データが生成される場所での処理)への関心が高まりを見せており、実際グーグルやメタといった大手テック企業によるエッジモデルの開発が急ピッチで進展している。たとえば、グーグルのAndroid向けAIモデル「Gemini Nano」やメタの「LLaMA-3.2」などが挙げられる。アップルも独自にモバイルデバイス向けAIモデルの開発を推進中だ。

直近では2024年11月に発表されたアドビの「SlimLM」が注目されている。

SlimLMの開発にあたり、アドビの研究チームは、様々な設定でテストを実施。その結果、最小モデル(1億2,500万パラメータ)でも、スマートフォン上で800トークン(800字ほど)程度の文書を効率的に処理できることが判明。10億パラメータまでスケールアップ可能な大型バージョンは、より大きなモデルに匹敵する性能を実現しつつ、モバイルハードウェア上でもスムーズな動作を維持できることが実証された。

既存の大規模モデルを単に縮小するのではなく、モデルサイズ、文脈の長さ、推論時間の最適ポイントを見出す一連のプロセスによる成果となる。

特筆すべきは上記のFastinoと同様、ビジネスにおける特定タスクに特化する工夫が施されている点だろう。たとえば、要約や質問応答などの文書関連タスク向けには、特化型の学習データセット「DocAssist」が作成され、トレーニングで活用された。汎用的なインターネットデータに依存せず、ビジネス用途に特化したトレーニングを行ったことが、専門タスクでの高い精度を実現した大きな要因となった。

Macの進化とExoパッケージ:大規模モデルをローカルで利用

各社のAIモデルの進化と並行し、ハードウェアの進化も著しい。2024年10月末に発表されたアップルの新型「M4」チップ搭載の各種モデルは、オープンソースLLMを利用できるハードウェアとしてAIコミュニティで大きな注目を集めている。メタの「Llama-3.1 405B」、NVIDIAの「Nemotron 70B」、アリババの「Qwen 2.5 Coder-32B」など、数万〜数十万ドルのGPUクラスターが必要とされる高性能モデルを実行できることが披露された。

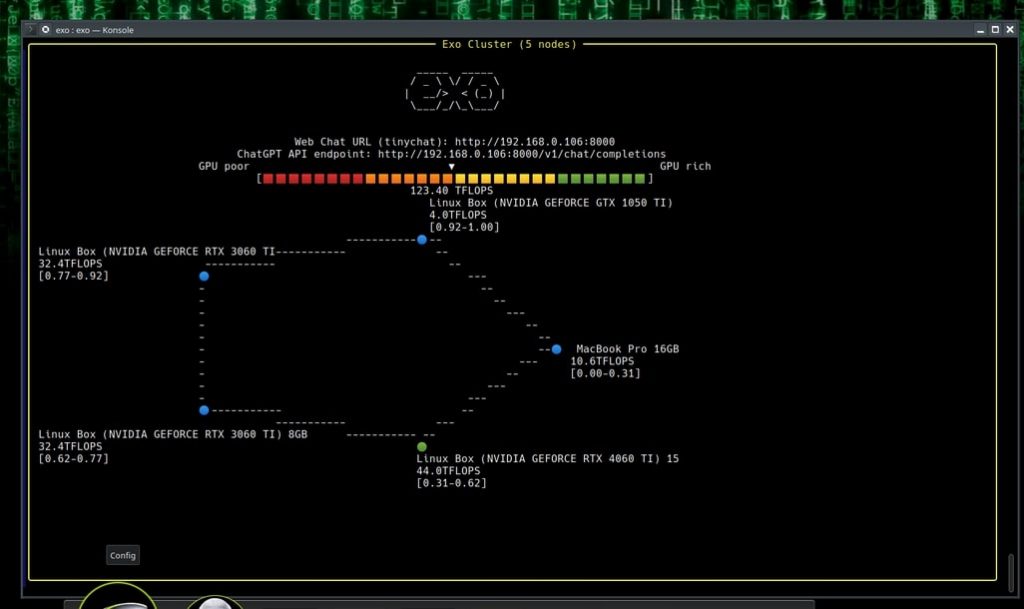

この可能性を実証したのが、最近設立されたExo Labsの共同創業者、アレックス・チーマ氏だ。同氏は4台のMac Mini M4(1台599ドル)と1台のMacbook Pro M4 Max(1,599ドル)を接続し、Exoのオープンソースソフトウェアを使用して「Qwen 2.5 Coder-32B」を実行することに成功した。このクラスターの総コストは5,000ドル。市場価格3〜4万ドルともいわれるNVIDIA H100 GPU(1台)と比べても遥かに低いコストとなる。

https://x.com/alexocheema/status/1860369093674582369

Exo Labsの成功は、アップルのM4チップの性能に負うところが大きい。M4シリーズは、アップルが「世界最速」と主張するGPUコアを搭載しており、シングルスレッドタスク(単一のCPUコアで動作するタスク)でのパフォーマンスは最高水準といわれている。チップの仕様が事前にリークされていたこともあり、チーマ氏はM4の性能に確信を持っていたという。

実際の性能を見ると、Mac Mini M4クラスターは、Qwen 2.5 Coder 32Bを1秒間に18トークン、Nemotron-70Bを1秒間に8トークンの速度で処理できる。また、2台のMacbook Pro M3を接続してLlama 3.1-405Bを実行した場合でも、1秒間に5トークン以上の処理速度を達成している。

この実証実験で利用されたソフトウェアは、Exo Labsが開発したもので、複数のデバイスにAIワークロードを分散させることができる。上記の実証実験では、いわゆるM4のベースモデルが利用されているが、より高スペックなモデル(メモリ64GBや128GBなど)を使うことで、さらに高いパフォーマンスを求めることも不可能ではない。

https://github.com/exo-explore/exo

ローカルデバイスでのAIモデル稼働は、コスト、プライバシー、セキュリティ面で大きな利点を持つ。FasinoやExo Labsの取り組みは、特に規制の厳しい業界で活動する企業や、コストを重視しつつ最新のAIモデルを活用したい企業にとって興味深い示唆となるはずだ。

文:細谷元(Livit)