INDEX

リアルタイムをめぐる競争:グーグルが示すリアルタイムマルチモーダルの未来

大規模言語モデル(LLM)開発における、この1年の大きな躍進の1つとして、高精度を維持したスピードの大幅向上が挙げられる。その最前線に立つのが、グーグルが2024年12月に発表した「Gemini 2.0 Flash」だ。

Gemini 2.0 Flashは従来のGemini 1.5 Proと比較して2倍の処理速度を実現。この高速化により、スマートフォンのカメラを通じて撮影される映像をリアルタイムで分析し、その内容についてユーザーと対話することが可能となった。動画や音声、画像、文書など、複数の形式のデータを同時に処理できるマルチモーダル機能を備え、音声出力にも対応している。

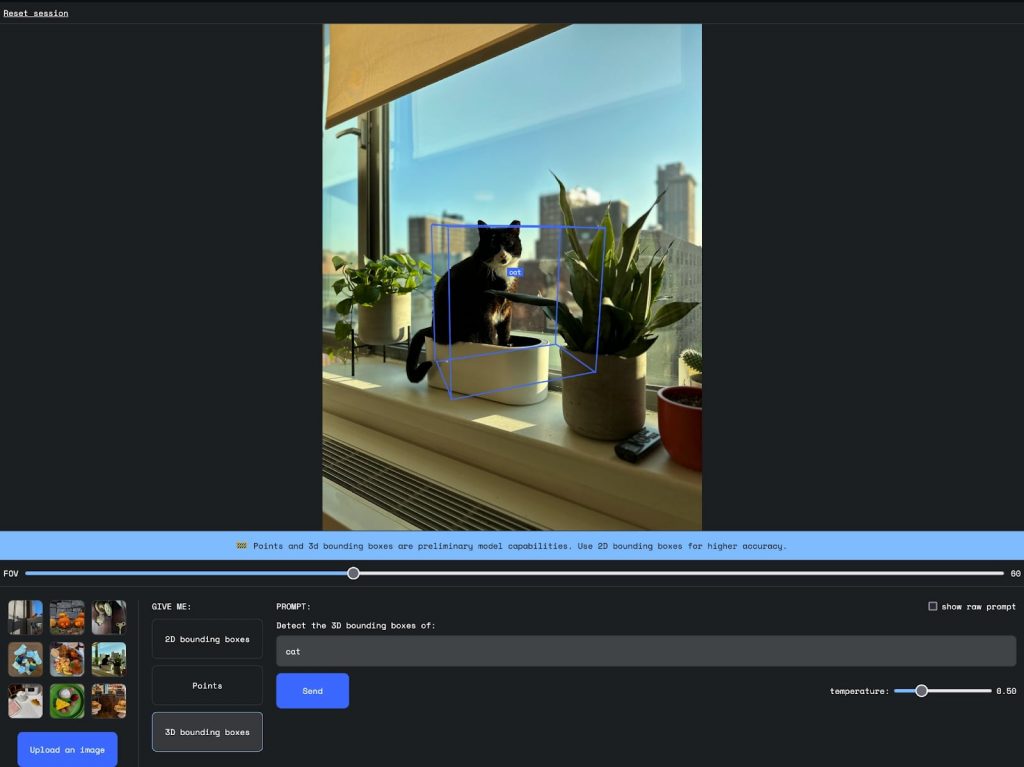

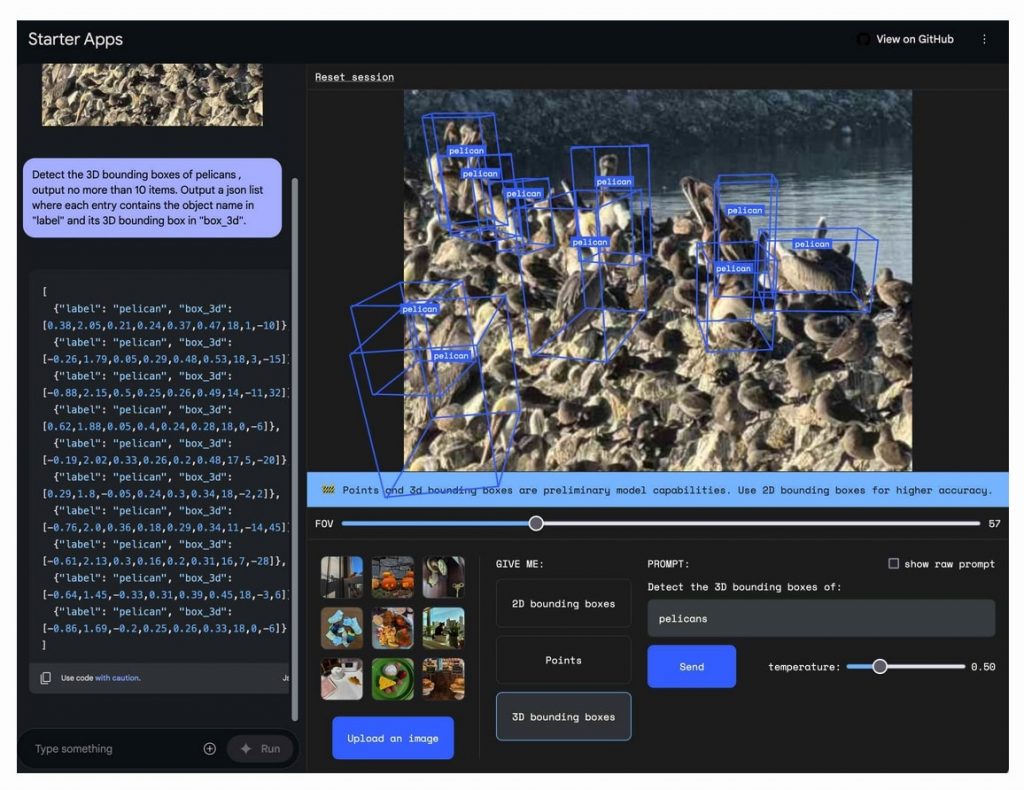

グーグルのAI Studioを通じて提供されるライブ機能により、Chromeなどでこのリアルタイム機能を体験することができる。動画データの分析に加え、グラフの描画やPythonコードの実行も可能だ。興味深いのは、Gemini 2.0 Flashに空間認識能力が備わった点だろう。AI Studioで用意されているテスト画像を使って、猫の3次元ポジションを検出させたところ、かなり正確なポジションを描画することができた。

https://aistudio.google.com/starter-apps/spatial

また開発者であるサイモン・ウィリソン氏がさらに複雑な画像(複数のペリカンが写った写真)を使い空間認識能力の実験を行ったところ、複雑な写真の中から正確にペリカンの位置を特定し、3次元境界ボックスを生成することに成功した。

https://simonwillison.net/2024/Dec/11/gemini-2/

これらの機能の組み合わせにより、たとえばAdobe Premiere Proでの動画編集作業において、初心者でも数秒でブラー効果の追加方法を習得できるなど、実践的なユースケースが生まれている。

この分野における競争は激化の一途だ。OpenAIは「Advanced Voice Mode with Vision」を発表し、マイクロソフトも「Copilot Vision」のプレビュー版をリリース。AnthropicもClaude 3.5の高速版である「Haiku」を投入したばかり。

現在実験段階であるリアルタイム機能を実用化できる水準に高めるには、グーグルが言及しているように、いくつかの課題を克服する必要がある。1つはメモリの問題。リアルタイムストリーミング機能(Project Astra)のコンテキストメモリは、セッション内で最大10分間に限定される。また、サードパーティAPIへのアクセスやコード実行機能など、プライバシーとセキュリティの観点からも慎重な対応が求められる。

リアルタイム動画分析がもたらす新たな可能性

リアルタイムのユースケースを追求するのはグーグルだけではない。

AIスタートアップのEndlessAIは、リアルタイム動画分析iOSアプリ「Lloyd」を展開、すでに多くのユーザーを獲得している。

同アプリは、独自の動画ストリーミングおよびエンコーディング技術とOpenAIのGPT-4oなどのLLMを組み合わせ、ユーザーが撮影している動画をリアルタイムで分析することができる。これにより、自転車の修理から就寝前の物語の朗読まで、幅広いタスクをサポートすることが可能となった。

2024年10月のステルスローンチから3カ月で5万人以上のユーザーを獲得。そのうち41%が毎日アプリを利用しているという。ユーザーからは、料理の準備、家の修理、ファッションやライフスタイルのコーチングなど、幅広い用途での活用が報告されている。

同社技術の最大の強みは、非常に高い処理効率を実現できる仕組みにある。既存のLLMを使った従来の方法で、動画分析を実行しようとすると非常に高額なコストがかかる。たとえばChatGPTで動画分析を行う場合、1時間あたり数百ドルものコストを要するとされる。これに対し、Lloydでは同レベルの精度を1時間あたり数十セントにまでコストダウンすることに成功した。

直近では、Lloydアプリは「Powers(パワーズ)」と呼ばれる機能を実装、特定用途でさらに高い精度で利用することができるようになった。その第一弾として登場したのが「Chef(シェフ)」。これは、ユーザーがスマートフォンのカメラをコンロや調理エリアに向けると、AIがリアルタイムで調理をコーチングするという機能だ。さらに、周辺の観光スポットやアクティビティを推奨する「Tour Guide(ツアーガイド)」の提供も計画されている。

AI検索もリアルタイムに、Perplexityの取り組み

短期間で90億ドルにまで評価額を上げたPerplexityもリアルタイム分野で存在感を示す。

同社は2025年1月、リアルタイム検索を可能にする「Sonar」をリリースした。開発者や企業向けにリアルタイムのウェブ検索機能を提供するAPIだ。

基本的な機能を提供する通常版と、より高度な機能を備えたPro版の2つのバージョンで展開される。価格設定は、通常版が1,000回の検索あたり5ドルにトークン料金を加えた額。一方のPro版は、より高額なトークン料金が設定されているものの、引用頻度が2倍になり、複雑なクエリに対するマルチサーチ機能も利用可能になるという。

すでにZoomは、Sonarを「AI Companion 2.0」に統合。これにより、ユーザーはビデオ会議中にアプリを離れることなく、リアルタイム情報にアクセスできるようになった。Zoomのチーフテクノロジーオフィサーであるシュエドン・ファン氏によると、この統合によってAI Companionの知識ベースが拡張され、ユーザーは複数のリンクを切り替えることなく、会議中やワークフロー内で最新のウェブ情報にアクセスできるようになったという。

たとえば、クライアントミーティングにおいて、従来のようにZoomとグーグル検索を行き来する必要がなくなり、Workplaceのサイドパネルで質問を投げかけるだけで、数秒で必要な回答が得られるようになった。さらに、会議後のワークフローも効率化され、通話の要約から、ブロッカー(障害)のトップ5、成果のトップ5、未解決の質問などを特定のフォーマットで自動的に整理することができるようになった。

検索はもともとPerplexityが強みとする領域。回答における精度(事実性)を測るSimpleQAベンチマークにおいて、Sonar ProはOpenAIなどの競合モデルを上回る85.8のFスコアを達成している。

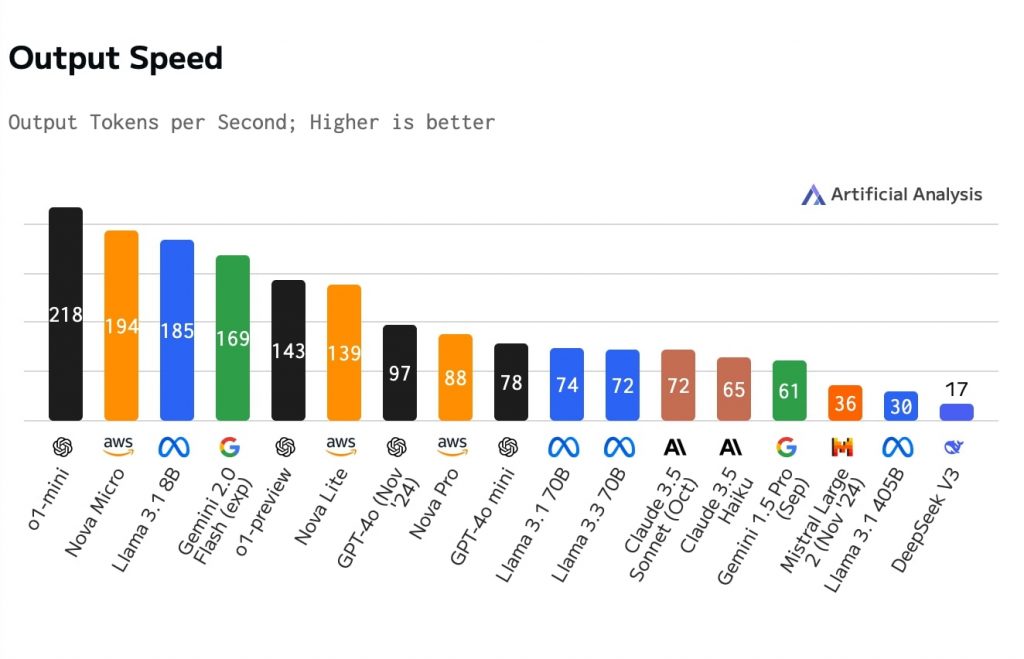

https://artificialanalysis.ai/

Artificial Analysysのデータ(2025年1月22日時点)を見ると、主要モデルの中で1秒間の生成スピードが100トークンを超える高速モデルは7つ、また100に近いモデルも複数確認できる。今後は、これらの高速モデルを活用したリアルタイムAIアプリケーションが増加する見込みだ。

文:細谷元(Livit)