メタがモバイル向け「超小型」AIモデルを発表 加速するAIモデルの小型化、20倍大きいモデルに匹敵も

INDEX

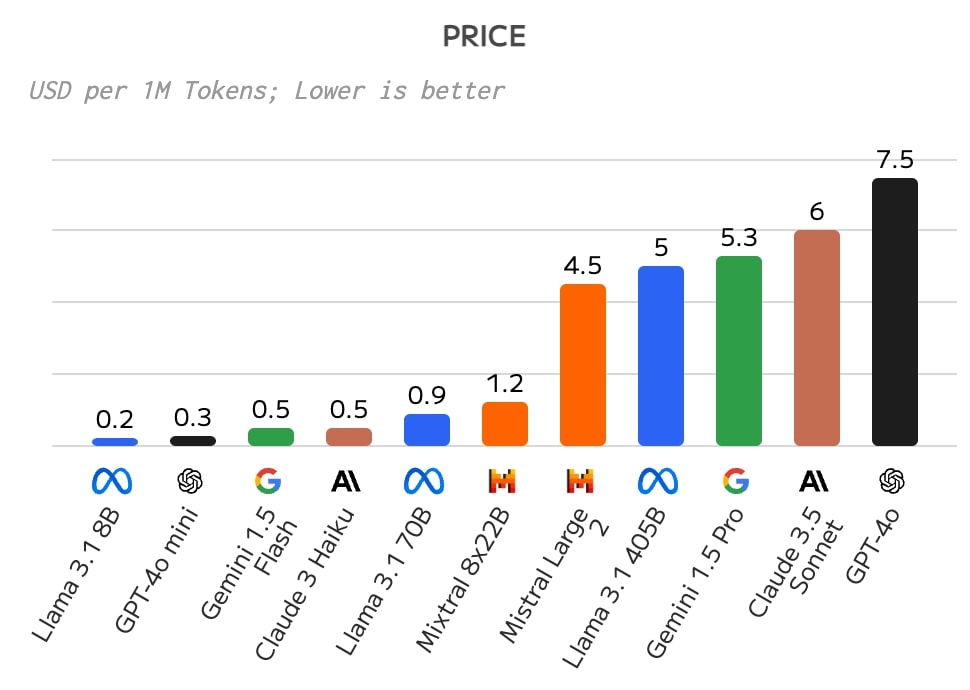

言語モデルのコスト、最新のLlama3.1 405Bモデルの例

AIの世界では、モデルのサイズ(パラメータ数)が大きければ、性能も高くなる傾向があるため、巨大なモデルを開発しようという動きが目立っていた。しかし、開発と運用にかかる莫大なコストが問題視され、より小型で効率的なモデルを求める声が高まっている。たとえば、OpenAIのフラッグシップモデルGPT-4のパラメータ数は、1兆以上あると推定されており、運用するために日々膨大な計算処理コストが発生、それがエンドユーザーの(API)コストに転嫁されているのだ。

https://artificialanalysis.ai/

GPT-4と同等の性能を持つメタのLlama3.1 405B(4,050億パラメータ)モデルも、開発における効率化によりパラメータ数はGPT-4の半分以下になったが、それでも想定される運用コストは安くない。

Artificial Analysisの分析によれば、Llama3.1 405Bモデルのパラメータを格納するには810GBのメモリが必要で、さらに30%の追加メモリを考慮すると、合計1053GBのメモリ容量が必要になるという。

この巨大なメモリ要件を満たすため、GPUの選択が重要になってくる。

AMDの最新GPU「Antares」Instinct MI300Xは、1枚で192GBのメモリを搭載しており、8枚で1,536GBとなる。これはLlama 3.1 405Bモデルを余裕を持って動かせる容量だ。一方、NVIDIAのH100 GPUは1枚80GBのメモリしかないため、16枚(1,280GB)必要となる。

コスト面を見てみると、AMDのMI300Xは1枚約2万ドル(約300万円)と推定される。8枚で16万ドル(約2,400万円)。NVIDIAのH100は1枚2万2,500ドル(約340万円)で、16枚では36万ドル(約5,400万円)になる。さらに、GPUを搭載するサーバー本体のコストも加えると、AMDのシステムは約31万ドル(約4,650万円)、NVIDIAのシステムは約51万ドル(約7,650万円)に達するのだ。

プライバシー/セキュリティの観点から、GPT-4などクラウドベースの言語モデルを利用したくないという企業は、Llama3.1 405Bモデルのようなオープンソースモデルを自社サーバーで運用することが可能ではあるが、この規模のモデルをスムーズに運用するには、少なくとも数千万円から1億円近いコストがかかることを念頭に置く必要がある。

より小型に、10億以下のパラメータ、メタの試み

こうしたコスト問題が広く認知されていく中、小型モデルへの需要が高まっている。

NVIDIAとMistralがこのほど共同で発表した「Mistral NeMo」などは、高まる需要を反映するモデルといえるだろう。Mistral NeMoは、120億パラメータを持ち、コンシューマグレードのGPU「RTX4090」1台で運用可能とされるモデルだ。RTX4090自体は、20〜30万円ほどで入手できるため、コストを大幅に下げることが可能となる。

AIモデルの小型化は、今後さらに加速する公算だ。

メタは2024年6月末、パラメータ数が数億という「超小型モデル」の研究論文を発表。モバイルデバイスやエッジデバイスでの言語モデル利用を普及させる構えを示したのだ。この研究論文で公開されたのは、「MobileLLM」と名付けられた超小型言語モデル。スマートフォンなどリソースに制約のあるデバイス向けに設計されている。

MobileLLMの特徴は、そのコンパクトさにある。従来の大規模モデルが数十億から数兆のパラメータを持つのに対し、MobileLLMは10億未満のパラメータで構成されているのだ。具体的には、125M(1億2,500万パラメータ)と350M(3億5,000万パラメータ)の2つのバリエーションが開発された。

このサイズは、特にスマートフォンでの利用に最適化されたものとなっている。

たとえば、iPhone 15のDRAM(メモリ)容量は6GB、Google Pixel 8 Proでは12GB。メタの研究者らは、モバイルアプリはDRAMの10%以上を使用すべきではないと指摘している。なぜなら、DRAMはオペレーティングシステムや他のアプリケーションと共有されるからだ。

この主張のもと、研究者らは3億5,000万パラメータのMobileLLMが必要とするメモリを約350MBに抑えることに成功。これは一般的なスマートフォンのDRAM容量の5%以下に収まる計算になる。ユーザーの日常的なスマートフォン使用に支障をきたすことなく、高度なAI機能を提供できる可能性が示された格好となる。

メタの超小型モデル、その実力とは?

では、メタが開発したMobileLLMの性能を具体的に見ていきたい。MobileLLMは、従来の大規模モデルに比べてはるかに少ないパラメータ数でありながら、驚くべき成果を上げている。

まず、ゼロショット常識推論タスクにおいて、MobileLLM-125Mは平均46.3%のスコアを達成した。このタスクは、モデルが事前学習以外の特別な訓練なしに、一般的な知識や常識を理解し適用できるかを測定するものだ。MobileLLM-125Mのスコアは、同じパラメータ数のOPT-125Mの42.6%、GPT-neo-125Mの42.9%を4ポイントほど上回る結果となった。さらに、MobileLLM-350Mは51.3%という高スコアを記録し、Pythia-410Mの46.6%やRWKV-430Mの47.0%を超えた。

質問応答タスクのTriviaQAでも、MobileLLMは優れた性能を示した。TriviaQAは、幅広い分野の質問に答える能力を評価するベンチマークだ。MobileLLM-125Mは1ショット(1つの例を示す)で13.9%、5ショットで14.3%、64ショットで12.5%のF1スコアを達成。これは、OPT-125MやGPT-Neo-125Mの2倍近い性能だ。MobileLLM-350Mになると、さらに性能が向上し、1ショットで22.0%、5ショットで23.9%、64ショットで24.2%という高スコアを記録している。

読解タスクのRACEにおいても、MobileLLMは既存モデルを上回る結果を示した。RACEは、中学・高校レベルの英語試験問題を基にした読解力テストだ。MobileLLM-125Mは中学レベルで39.7%、高校レベルで28.9%の正解率を達成。MobileLLM-350Mは中学レベルで45.6%、高校レベルで33.8%という高い正解率を記録した。

また人間らしい対話能力を評価するベンチマークAlpacaEvalで、MobileLLM-LS-350Mは、GPT-3モデル(text-davinci-001)に対して48.2%のウィン率を達成。3億5,000万パラメータのモデルが、130億パラメータのtext-davinci-001モデルに並ぶ快挙を記録した。

さらに注目されるのが、APIコーリングテストでの記録だ。このテストは、自然言語の指示をプログラミングAPIの呼び出しに変換する能力を評価する。人間の意図を正確に理解する「意図の正確な一致率」で65.3%を記録、APIの構造を正確に生成する「構造の正確な一致率」で48.8%を達成したのだ。これは、20倍の規模を持つLlama2 7B(70億パラメータ)の記録、意図の一致率62.8%、構造の一致率50.9%に並ぶもの。モバイルデバイス搭載のAIで、スマートホームデバイス操作などができるようになる可能性を示す結果といえるだろう。

メタがこうした超小型モデルをどのように活用するのかが気になるところ。WhatsAppやMessengerなどのメッセージングアプリでの活用やクエストVRヘッドセットに導入するといったシナリオも考えられる。モバイルデバイスに搭載可能な超小型モデルは、アップルなども注力する分野。OpenAIもGPT-4o miniをリリースするなど、小型/超小型モデルをめぐる競争はさらに激化していきそうだ。

文:細谷元(Livit)