GPT-4oの価格が大幅値下げ、競合に対抗するOpenAIの静かなアップデート その裏で進行している極秘プロジェクトとは

INDEX

激化する大規模言語モデル開発競争、OpenAI、Anthropic、グーグル、メタ、xAI

大規模言語モデルをめぐる状況は、この1年で大きく変化した。1年ほど前まで、OpenAIのGPT-4が他モデルを圧倒するパフォーマンスを示していたが、その後、Anthropicやグーグルのモデル性能が大幅に向上、またメタのLlama3.1 405Bの登場でオープンソースモデルにも注目が集まるようになっている。

たとえば、Anthropicが2024年6月21日にリリースした「Claude3.5 Sonnet」は、多くのベンチマークでGPT-4を上回る性能を示す。「LiveBench(2024年8月15日時点)」によると、Claude3.5 Sonnetは総合平均スコアで59.87を記録し、2位のGPT-4o(56.71)を超え、1位を獲得。またClaude3.5 Sonnetは、コーディング能力の向上が顕著で、コーディングに特化したベンチマーク「LiveCodeBench(2024年8月15日)」では、Pass@1スコアで51.3%を記録し、2位のGPT-4o(45.2%)を大きく引き離しているのだ。

メタが2024年7月23日に発表したLlama3.1 405Bも、GPT-4に匹敵する性能を持つことが明らかになった。Llama3.1 405Bは、一般的な知識や推論能力を測るMMLUで88.6%を獲得、GPT-4oの88.7%、Claude 3.5 Sonnetの88.3%と肩を並べる性能を示した。コーディング能力を測るHumanEvalでも89.0%を獲得し、GPT-4oの90.2%、Claude 3.5 Sonnetの92.0%に迫る水準に至る。

グーグルが2024年8月1日にリリースしたGemini-1.5-Pro-ExpもLMSYSのChatbot Arenaリーダーボードで1,297点を獲得、8月12日のアップデート時点でGPT-4o(2024-08-06)に次ぐ2位となっている。

さらには、イーロン・マスク氏のAI企業xAIも巨大なスパコンクラスターで強力なAIモデルをトレーニングしており、このほどリリースしたGrok-2に続き、年内にさらに高性能のモデルを発表する見込みだ。xAIのデータセンターは10万台に上るH100で構成されており、強力なAIモデルの登場が期待される。

OpenAIのGPT-4oアップデート、価格大幅値下げで競合モデルに対抗

続々登場する競合モデルに対し、OpenAIは、GPT-4のアップデートを重ね対抗している。

直近のアップデートで注目されるのは、7月末に発表された「GPT-4o Long Output」のリリースだろう。従来のGPT-4oモデルのアウトプットは4,000トークンだったが、このモデルはその16倍となる6万4,000トークンを生成できるという。ユーザーからのフィードバックにより、試験的にリリースされたモデルで、特にコード編集や文章生成など、詳細かつ広範な出力が求められるシーンでの活用が想定されている。

注目すべきは、GPT-4o Long Outputの価格だ。入力トークンは100万トークンあたり6ドル、出力トークンは100万トークンあたり18ドルとなっている。従来のGPT-4oの価格は、入力5ドル、出力15ドル。価格を若干上乗せするだけで利用できる点は、特筆に値する。通常のGPT-4oモデルの出力4,000トークンとは、日本語換算で約4,000文字に相当する量。一般的なチャットであれば十分な量であるが、コーディングなどでは、4,000トークンでは足りないケースも出てくる。6万4,000トークンモデルを従来モデルとほぼ変わらない価格で利用できるのは、開発者/エンドユーザーにとって魅力的だ。現在、競合モデルはほとんどが出力4,000トークンだが、これを機に長文出力モデルが増えてくる可能性もある。

2024年8月6日にもGPT-4oの最新版のリリースと価格改定が実施され、ユーザーを驚かせた。価格改定では、これまでのインプット5ドル、アウトプット15ドルから、インプット2.5ドル、アウトプット10ドルに大幅値下げされた。競合となるClaude3.5 Sonnetのインプット5ドル、アウトプット15ドルを意識した値下げとみられる。

このアップデートでは、GPT-4oの精度が若干向上したとの報告もなされている。

実際LMSYSのリーダーボードでは、GPT-4o‐2024‐08‐06モデルが1314ポイントを獲得し、1,297ポイントのGemini-1.5‐Proを凌駕、トップに返り咲いた。Cluade3.5 Sonnet(1,272ポイント)やLlama3.1 405B(1,263ポイント)に対しても優位性を見せている。

OpenAIの極秘プロジェクト「Strawberry」

現在、OpenAIの動向でとりわけ注目されているのがプロジェクト「Strawberry」だ。ロイター(2024年7月12日)の報道によると、OpenAIが「Strawberry」というコードネームのもと、新しい推論技術の開発に取り組んでいることが明らかにされた。

Strawberryの詳細は、OpenAI社内でも厳重に機密扱いされているという。ロイター通信が独自に入手した内部文書によると、このプロジェクトの目的は、AIが単に質問に答えるだけでなく、インターネットを自律的に操作して「Deep Research」を行う能力を開発することにあるとされる。

OpenAIのサム・アルトマンCEOは今年初め、「AIにおいて最も重要な進歩は推論能力に関するものになるだろう」と発言。実際、推論は、AIが人間レベルまたは超人間レベルの知能を達成するための鍵だと、多くの研究者が指摘するところ。

Strawberryプロジェクトの特徴の1つは、AIモデルの性能を向上させる新しい手法を採用している点だ。この手法は「ポストトレーニング」と呼ばれ、AIモデルが一般的な大量のデータで学習した後、さらに特定の課題に特化した調整を行うプロセスを指す。この方法は、2022年にスタンフォード大学が開発した「Self-Taught Reasoner(STaR)」という技術に似ているという。STaRでは、AIが自ら新しい学習データを作り出し、それを使って自身の能力を向上させていく。これにより、AIの知能レベルを段階的に引き上げることができるのだ。

Strawberryプロジェクトの目標の1つは、AIモデルの「長期展望タスク(LHT)」の実行にあるとされる。長期展望タスクとは、複雑で長期的な課題に対し設定される一連のタスクのこと。難しい目標を設定し、それを実現するには、どのようなアクションが必要なのかを自ら考え、実行するAIモデルだ。この目標を達成するため、OpenAIは「Deep Research」と呼ばれる特殊なデータセットを用いて、AIモデルの開発、トレーニング、そして評価を行っているという。

このプロジェクトが成功すれば、インターネット上で独自に情報を収集し、分析することができるAIモデルが登場する可能性がある。またOpenAIは、このAIモデルにソフトウェア開発や機械学習の専門家レベルの作業を行わせる実験も計画しているとのこと。

Strawberryは、以前「Q*」と呼ばれていたプロジェクトの発展形だと考えられている。ロイターの昨年の報道によると、Q*はOpenAI社内ですでに画期的な成果として認識されていたという。さらに今年初めには、Q*のデモンストレーションを目撃したという情報筋の証言もある。このデモでは、現在の商用AIモデルでは解けないような高度な科学や数学の問題を解く能力が示されたとのことだ。

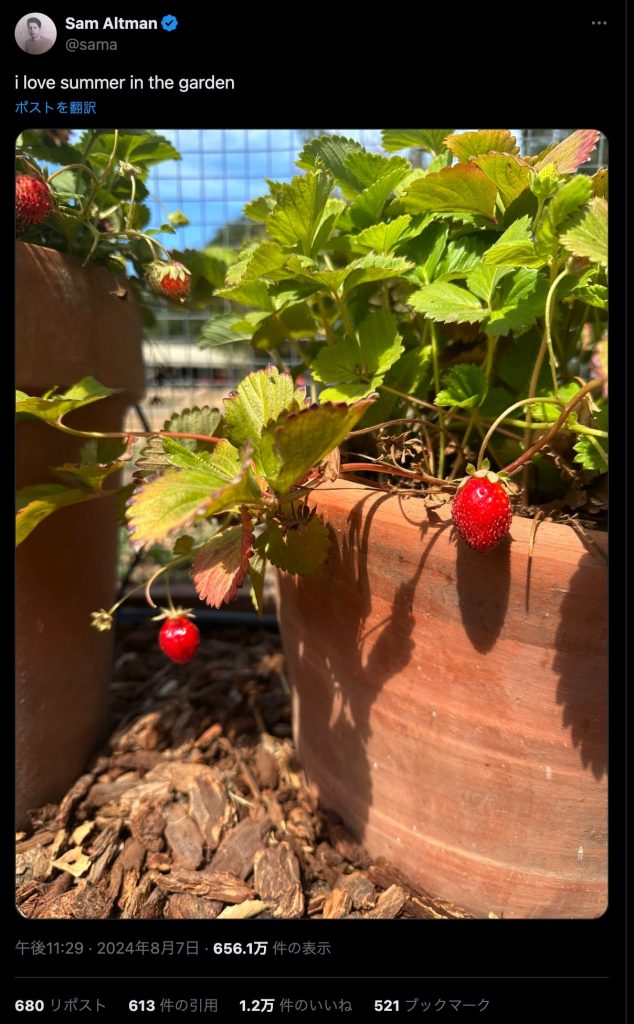

2024年8月7日、アルトマンCEOがXでイチゴの写真を投稿したことで、Strawberryプロジェクトに関する憶測はさらに広がりを見せている。

文:細谷元(Livit)