生成AIアプリ展開で迫られる選択、APIかセルフホストか? コストの違いを探る

INDEX

APIとオープンソース、コストの違い

企業が生成AIアプリケーションを展開する際、言語モデルを選択する必要がある。選択肢は、OpenAIやAnthropicのAPIを利用するか、オープンソースのLLMをセルフホストするか、大きく2つに大別される。

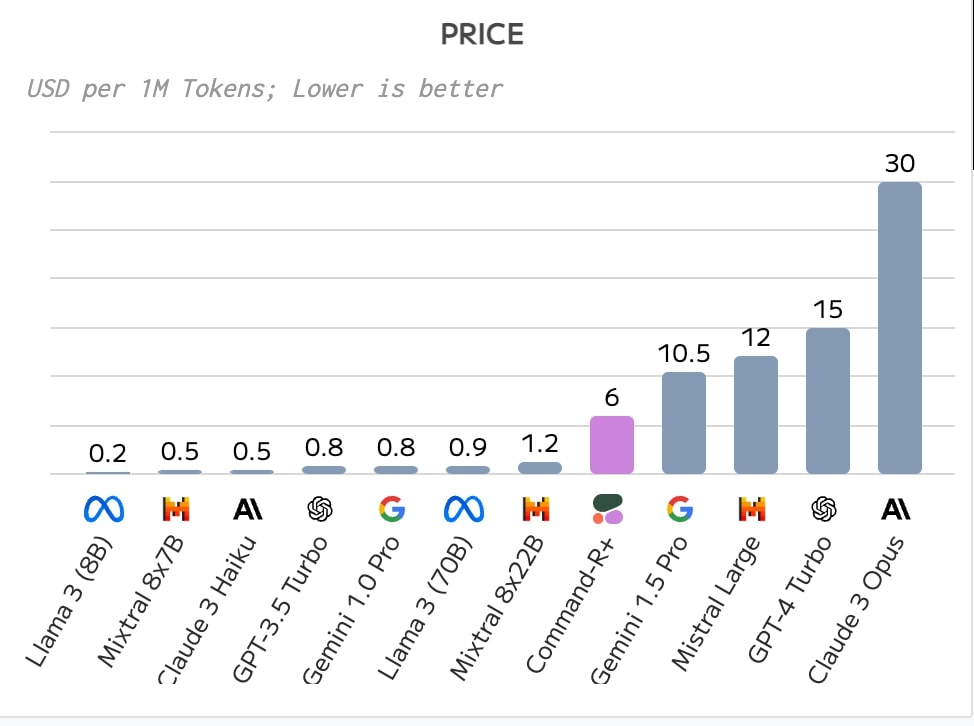

OpenAIであれば、GPT-3.5 TurboやGPT-4 Turboなどを選ぶことができ、かつGPT-3.5 Turboであれば、自社データで調整したファインチューニング版を展開することも可能だ。GPT-3.5 TurboのAPI利用料は、インプット100万トークンあたり0.5ドル、アウトプット100万トークンあたり1.5ドル。一方、GPT-4 Turboは、インプット10ドル、アウトプット30ドルとなる。

また、GPT-3.5 Turboを使ったファインチューニングのコストは100万トークンあたり8ドル、推論のコストはインプット100万トークンあたり12ドル、アウトプット16ドルとなる。このように、ほとんどのAPIは利用量に応じて料金が発生する従量課金制が採用されている。初期コストはかからないものの、利用が増えるほど料金も増大するリスクがある。

一方、オープンソースのLLMをセルフホストする場合、代表的なモデルとしてはLLaMA2やMixtral8×7Bが挙げられる。APIのようにトークン量に応じた従量課金はなく、無料で利用することができる。ただし、モデルを展開するには、自社サーバーかクラウドを利用する必要があり、これらにかかるコストを計算しなくてはならない。

また生成AIアプリケーションの展開では、モデルにかかるコストだけでなく、プロジェクト全体の費用も念頭に置くことが求められる。米国では、概念実証(PoC)には3〜6万ドル、MVP(ミニマル・バイアブル・プロダクト)には9〜12万ドルのコストがかかり、初年度のメンテナンスまで含めると50万ドル以上になるとの試算もある。たとえば概念実証の段階で、エンジニア1〜2人、プロジェクトマネジャー1人で3〜4週間かかるとすると、3万〜6万ドルのコストになるのは妥当なところといえそうだ。

コスト以外にも、APIとセルフホストにはそれぞれメリットとデメリットがある。APIの場合、最新のモデルをすぐに利用できるメリットがある一方、データをクラウドに預ける必要があり、セキュリティやプライバシーを懸念する声は依然多い。セルフホストの場合、データを自社で管理できるメリットがある反面、インフラ構築や運用の手間がかかる。また、最新のモデルを利用するには、自社でアップデートする必要がある。

企業は、コストだけでなく、セキュリティ、パフォーマンス、運用の手間なども考慮しながら、APIとセルフホストを選択する必要がある。以下では、それぞれのコストについて、より詳しく見ていきたい。

API利用におけるコスト、OpenAI、Anthropic、Cohereなど

OpenAIなどのAPIを使って生成AIアプリケーションを展開する場合、どれほどのコストが発生するのだろうか。

OpenAIのAPIでは大きくGPT-3.5 TurboとGPT-4 Turboの2つのモデルが提供されている。冒頭でも触れたが、料金体系はトークン量に応じた従量課金制で、トークンは入力トークンと出力トークンに分かれる。たとえばGPT-4 Turboの場合、インプット100万トークンあたり10ドル、アウトプット30ドルとなる。

英語であれば100トークンが75ワードほど、日本語であれば100トークンが100文字ほどの長さに換算される。A4サイズのドキュメント1ページあたりの文字数は、英語で約400ワード、日本語で約1,400文字ほど。つまり、英語であれば1875ページ分のアウトプットを生成すると、30ドルかかる計算となる。GPT-3.5 Turboであれば、1.5ドルとコストは20分の1に下がる。

これを念頭に、展開する生成AIアプリケーションが1リクエストあたり平均3,000トークン、1分あたり5リクエストを処理すると想定すると、トークン量は1分間で1万5,000トークン、1時間で90万トークン、1日で2,160万トークンとなる。インプットとアウトプットの混合価格(100万トークンあたり)をGPT-4 Turbo15ドル、GPT-3.5 Turbo0.8ドルで計算した場合、1日あたりの利用料はGPT-4 Turboが324ドル、GPT-3.5 Turboが17.28ドル。1カ月で計算すると、GPT-4 TurboのAPI利用料は9,720ドル、GPT-3.5 Turboが518ドルだ。

企業における生成AIユースケースでは、RAG(Retreaval Augmented Generation)というアプローチがベースとなる場合が多く、その場合、API利用料のほかにも、RAGにおけるベクトルデータベース利用料やドキュメントの読み込み・抽出にかかるAPI利用料なども追加されることになる。

OpenAI以外にも、AnthropicやCohereなどがAPIを提供している。AnthropicのClaude3は、GPT-4と同等以上の性能を持つとされるモデル。その最高峰となるClaude3 Opusの利用料は、インプット100万トークンあたり15ドル、アウトプットが75ドルとGPT-4よりも高く設定されている(混合価格は30ドル)。上記のシミュレーションを当てはめると、1カ月あたりのAPI利用料は、1万9,440ドルとGPT-4 Turboの2倍かかる計算だ。

OpenAI、Anthropic、Cohere、各社における現時点の最高峰モデルのAPIコストを比べると、CohereのCommand-R+が最も低コストで利用できるモデル。インプット100万トークンあたり3ドル、アウトプット15ドル、混合価格約6ドルで利用できる。上記のシミュレーションでも、1カ月のAPIコストは3,881ドルに抑えられる。

https://artificialanalysis.ai/models/command-r-plus

APIを利用する場合、トークン使用量が予想を上回ると、コストが急激に増大するリスクがある。トークン使用量を適切に管理し、コストを最適化するためには、LLMの特性を理解した上で、慎重にアプリケーションを設計する必要がある。プロンプトエンジニアリングやデータの前処理などを工夫し、無駄なトークン使用を減らすことが重要だ。

オープンソース大規模言語モデルを使う場合のコスト

では、オープンソースのLLMをセルフホストする場合、どれほどのコストがかかるのだろうか。

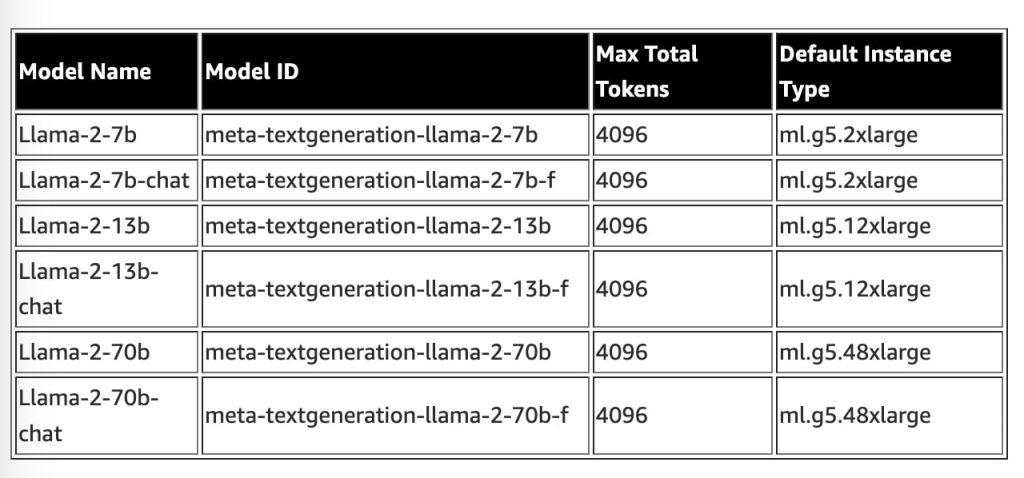

代表的なオープンソースLLMとしては、メタが提供するLLama2/3やMistralが提供するMixtral8×7Bがあるが、結論からいうと、モデルの規模(パラメータ数)によってセルフホストのコストは大きく変わってくる。

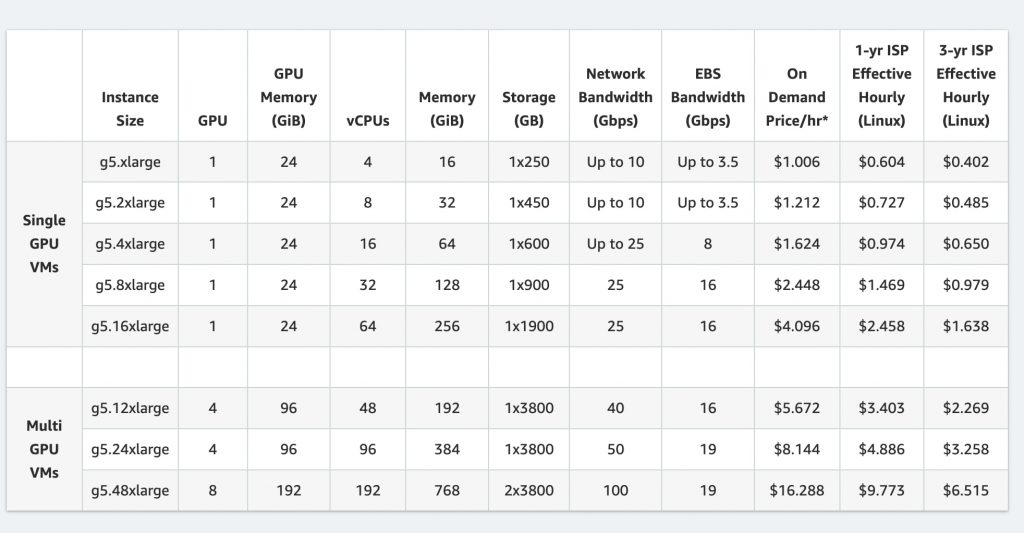

たとえば、Llama2の最も小さな70億パラメータのモデルをアマゾンAWSでホストする場合、推奨インスタンス(ml.g5.48xlarge)の1時間あたりのコストは約1.212ドル、1カ月では875ドルとなる計算だ。一方、130億パラメータのモデルでは、1時間5.67ドル、1カ月4,095ドルとなる。最大となる700億パラメータのモデルでは、1時間16ドル、1カ月1万1,768ドルかかる。

https://aws.amazon.com/jp/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

https://aws.amazon.com/ec2/instance-types/g5/?nc1=h_ls

オープンソースの場合、モデルの利用料自体は無料だが、APIを利用する場合と異なり、インフラ構築や運用の手間で、コストが増大する可能性には留意が必要だ。ファインチューニングなどを行う場合、データサイエンティストやMLエンジニア、インフラエンジニアなどの人員コストも無視できない。トレーニングデータの収集や前処理、モデルの評価や改善なども必要で、継続的なコストがかかる。

セルフホストに伴うこれらの間接コストを適切に見積もることは容易ではない。特に、運用の工数は、システムの規模や複雑性、要求される可用性のレベルなどによって大きく異なる。セルフホストのコストメリットを評価する際は、単にクラウドの利用料だけでなく、これらの間接コストも考慮する必要がある。

また、セルフホストでは、利用するオープンソースLLMのライセンスにも注意が必要だ。ライセンスによっては、商用利用に制限がある場合もある。法務部門などと連携し、ライセンス条項を確認することが必須だ。加えて、オープンソースLLMを利用する場合、コミュニティからのサポートは得られるものの、商用サポートは限定的である点にも注意したい。トラブル時の対応は、基本的に自社で行うことになる。

市場競争によりAPI価格にも下落圧力がかかっており、GPT-4も1年前に比べると価格は下がっている。またClaude3 Haikuのように、100万トークンあたりの混合価格が0.5ドルという低価格かつ高性能のモデルも増えつつある。クラウドの利用価格が現在の水準から変化しないとすると、さらなる高性能・低価格モデルの登場によりAPIの魅力が一層高まる可能性もありそうだ。

文:細谷元(Livit)