生成AIをめぐる規制動向、世界各国はAI原則を共有しつつ、それぞれの思惑反映した枠組みを導入

INDEX

AI市場の成長ポテンシャルとリスク

ChatGPTが火付け役となった生成AIトレンドだが、その市場成長ポテンシャルに関する予測レポートが多数発表されている。

たとえば、コンサルティング大手マッキンゼーが2023年6月に発表したレポートでは、生成AI活用による生産性向上により、2045年頃には最大で年間4兆4,000億ドルもの経済価値が追加される可能性があると予想されている。

また、Furtune Business Insightsは、2023年の生成AI市場規模を438億7,000万ドルと推計した上で、今後47.5%の年間成長率で拡大し、2030年には6,679億6,000万ドルに達すると予想している。

こうした強気の市場予測を背景に、現在テック大手を中心に生成AI関連の投資や研究開発が活発化しており、この勢いは2024年以降さらに加速する公算が高まっている。

一方で生成AIを含むAIテクノロジーに潜むリスクに対する懸念も増大しており、リスク最小化に向けた取り組みも国家アクターを中心に拡大しつつある。

ビッグ4会計大手の1つアーンスト・アンド・ヤング(EY)が2023年9月に発表したレポートによると、国家アクターによるAI規制議論において、複数の共通項が確認されるという。

1つは、各国では、OECDが定義しG20によって採択されたAI原則に沿った形で、AI規制・ガイダンス議論が進められているということ。この原則には、人権やサステナビリティ、透明性の尊重、また強力なリスク管理が含まれる。

もう1つの共通項は、AI規制において、各国がリスクベースのアプローチを採用しているということだ。

リスクベースのアプローチとは、AI規制・管理において、AIシステムの潜在的なリスクの程度に基づいて当局が異なる対応をとるアプローチを指す。

過去においては、新たなテクノロジーが登場した際、企業や業界団体による自主的な規制やガイドラインに依拠したものや規制の障壁を最小に抑えるイノベーション志向のものなどさまざまなアプローチがあった。一方で、AIテクノロジーの性質から、現在世界各地ではリスクベースのアプローチが趨勢となっているのだ。

このリスクベースに関する議論で最も進んでいるのが欧州連合(EU)。欧州議会では、AI規制に向け新たな法律「AI Act」が提案され、今後複数の議論と段階を経て施行される予定となっている。

現在までの議論で、リスクは「受け入れられないリスク」「高リスク」「限定的かつ最小のリスク」の3段階に分類され、それぞれに異なる対応が検討されている。

リスクレベルが最高となるのは「受け入れられないリスク」。たとえば、子どもに危険な行動を促す音声認識型のおもちゃ、行動・社会経済的地位・個人的特性に基づいて人々を分類するソーシャルスコアリング、顔認識を含むリアルタイムや遠隔での生体認識システムが含まれており、これらは完全に禁止される。

これに次ぐ「高リスク」に分類されるAIツールは、完全禁止とはならないものの、市場に出る前に厳しい審査・評価が求められる。企業が展開する人材採用AIシステムなど、個人の生活を大きく変えてしまうようなAI意思決定システムなどが対象となる。

「限定的かつ最小のリスク」には、Eメールのスパムフィルタなど悪影響が小さなAIシステムが含まれる。

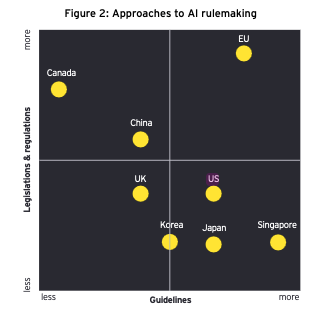

EYは同レポートで、法律・規制量とガイドライン量の2軸で主要国のAI規制アプローチをマッピングしているが、法律・規制とガイドラインの両軸で多いのがEUであり、世界の中で最も厳しいアプローチをとっていることを示唆するものとなっている。法律・規制の軸では、EUのほかカナダと中国が比較的厳しいアプローチをとっている。

一方、法律・規制ではなく、ガイドラインによるアプローチをとっている国も存在する。ガイドラインの多さでは、シンガポールが最多となり、これにEU、米国、日本、韓国、英国が続く格好となる。

米国のAI規制大統領令、100ページ以上の包括性に賛否

EYのレポートは包括的なものだが、同レポートが発表されて以来、世界のAI規制動向では大きな出来事がいくつか起こっており、情報のアップデートが必須だ。

特筆すべきは、2023年10月30日に発表された米国バイデン大統領によるAI規制大統領令(exuctive order)だろう。

この大統領令はAIの開発と利用に関して、広範囲に渡る原則とポリシーを定めるもので、内容は100ページを超える。テーマは経済と社会に加え、国家安全保障にも及んでおり、網羅的かつ包括的なものとなっている。

特に注目される内容としては、以下の点が挙げられる。

1つは、OpenAIやAnthropicなど強力な大規模言語モデルを開発する企業に対し、安全テストの結果やその他重要な情報を米国政府に共有すること。

この安全テストに関しては、米国標準技術研究所(NIST)が大規模言語モデルの安全性を検証するレッドチームテストの基準を設定することも盛り込まれた。

また、大規模言語モデルの買収・開発・保有についても都度連邦政府に報告することが求められる。大規模言語モデルの場所やコンピューティングパワーなど、詳細情報を報告する必要があるようだ。

米国はこの大統領令により、AIが生成したコンテンツ規制にも本格的に乗り出す構えだ。

大統領令では、米商務省に対し、AIが生成したコンテンツをラベル付けするウォーターマーク技術などに関する調査の実施を要求。またAIコンテンツを検知する技術や児童性的虐待などの画像生成を防止する技術の調査・評価も求めている。

今後AIによって失業者が増える可能性があるとの懸念にも対応する。

大統領令は、経済諮問委員に対し、AIが労働市場にもたらす影響を調査し、AIによって失業した労働者に対し政府機関がどのようなサポートを実施できるのかを分析するように要求。また既存の法的枠組みで、どこまで支援できるのかを評価することも求めている。

このAIに関する大統領令に対しては、賛否さまざまな意見があがっている。

VentureBeatが報じたところでは、特に広範囲に渡るトピックを扱っている包括性に対して、称賛する声と批判する声が聞かれるという。

非営利団体「AIとデジタル政策センター」のメルヴ・ヒコック会長は、大統領令が多面的な課題を扱っていることは正しい方向であるとして、大統領令の内容を評価。一方、Rストリート研究所の上級研究員であるアダム・ティエラー氏は、大統領令の包括性は行政のAI市場への過度な介入を招くものであり、米国の経済競争力だけでなく、地政学的安全保障さえも損なう可能性があるとの懸念を示している。

英国は、AI超大国目指す取り組み加速

英国も100ページに及ぶAI規制枠組みを表明しており、AI市場でのリーダーシップ確立に向けた動きを推進中だ。

米国の大統領令との比較で注目されるのは、英国がこの発表で「AI超大国(AI Superpower)」という言葉を何度も強調している点にある。

米国大統領令と英国のAI規制枠組み発表では、ともにAIの安全性・セキュリティ・責任、またAIのイノベーションや社会的・倫理的影響に対する共通認識が示されている。

しかし相違点も複数あることが観察される。

1つは、スコープと焦点だ。米国大統領令は広範囲なトピックを扱う包括的な内容となっている一方で、英国の枠組みは「pro-innovation(イノベーションを促進する)」環境の構築に焦点があてられている。

2つ目に、労働市場に対するアプローチも異なっている。米国大統領令はAIによる失業者増を見込み、職業訓練などの労働者支援を強調するものだが、英国の枠組みはAIの研究開発人材を多数抱える既存の強みをどのように生かすのかが主眼となっている。

英国はAI超大国を目指すことを公言しており、基本的なAIに関する懸念事項は共有しつつ、AI分野のイノベーションを加速させるための施策を進める方針だ。

文:細谷元(Livit)