AIは医療の人種格差を是正するか?マシンラーニングから見るテックと医療格差の現状と未来

INDEX

2020年の新型コロナウイルスの爆発的な蔓延は、社会に潜む多くの格差を照らし出した。リモートワークの有無や医療保険へのアクセスなど、日常生活の格差が直接生死に関わる確率も一気に上がった。特に米国内での医療システムに存在する医療格差は、新型コロナウイルスにおける「黒人死亡者は白人死亡者に比べ1.4倍という差があり、同時に死亡年齢がとても低い」[1]というデータに顕著に現れている。

これは Institutional racismと呼ばれる社会的構造に組み込まれた潜在的差別意識と大きく関係しており、医療分野で長年大きな課題として指摘されている。この中でも白人と黒人間での死亡率の格差は深刻で、長らく社会問題として議論されてきた。[2]白人平均余命が79歳なのに対して、黒人平均余命は75歳と4年もの差があるのだ。[3]

果たして人間の生死を決める医療システムに至るまで根強く存在している差別意識を改善することはできるのか?

人間よりもAIのほうが公平?

先月発表されたUC Berkeley Public Healthの研究チームがNature Medicineに掲載した論文によると、診断プロセスにAIを利用することによって医療格差を縮小できる可能性があることが分かった。

今までは医師たちの診断データを元に治療法を勧めていたが、直接レントゲン写真をAIに深層学習を用いて処理させることで白人以外の患者たちの誤診断が減ったという結果が出た。[4]

これは今後の医療格差を埋めていくうえで大きな影響を与えていくと期待されている。

社会的構造と医療格差の関係

2005年に全米医学アカデミー(National Academy of Medicine ; NAM)が発表したデータによると、所得や学歴などの要素の差を考慮したうえでも、黒人患者のほうが白人患者よりも圧倒的に劣った質の医療を受けていると明らかになった。[5]

これらの差別は医師たちが意図的に施しているものというより、社会の中で構築された差別的意識が潜在的に個人としての医師たちに偏見として存在し、診断における判断や処方に大きく影響していると言われている。

医療格差につながってくる暮らしの中に潜む差別として、学歴、所得、医療保険の加入、職業などが挙げられるが、これらは外的要因として患者の痛みや重症度に関係してくる。

本当の痛みはどれ?偏見を除くと分かる痛みの原因

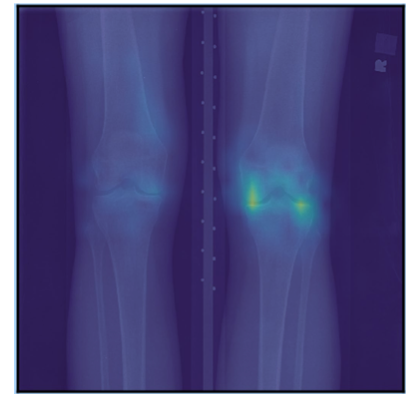

今回の研究では、最初に膝関節の変形性関節症のレントゲン写真から導く得点法(Kellgren–Lawrence grade (KLG))の信憑性を測ることで、得点法が実際の患者たちの痛みや実際の症状の重症度に対応していないことを明らかにした。

同じ症状のKLGと患者の自己申告制の痛み指数(Knee injury and Osteoarthritis Outcome Score (KOOS))を比べると、黒人患者のほうが痛み指数が高いという結果がある。そしてこれと同時に、医師たちは黒人患者の痛み指数を無視し、KGLのみでの診断を行う確率が非常に高いというデータが出ている。

これは黒人患者が大袈裟に痛みを申告しているか、KLGの得点方法自体に問題があるかのどちらかだ。

患者たちが自身の痛みを報告するKLGは元々イギリスで開発された指数であり、今回の結果から、指数開発の際に使用されたサンプルデータが偏っており、多様な人口層に適応していない可能性があると分かった。

これは、黒人患者や非白人患者たちに存在する特有の症状や骨格などを無視している可能性が高い。

今回の研究ではAIにレントゲン写真のみを処理させKOOSを予想した。結果、AIの予測のほうがKLGのものよりも圧倒的に正確であり、特に人種間における痛み相違点を約半分に削減した。

KLGは手術などに発展する症状を判断するうえでも重要な指数となっている。このことからKLGの精度の低さは誤診につながり、黒人患者たちに必要な治療を施すことを妨げ、同時にオピオイドといった鎮痛剤など効力の低い薬剤治療法を増加させる可能性があると論文は指摘している。

痛みとレントゲン写真、またその他の要素を総合的に考慮することが大きなポイントとなる変形性関節症において、この結果は長年のKLGの使用と医師たちの総合的な判断に潜む偏見を明るみに出し、患者たちの声の信頼度を上げるうえで大いに役に立つ。

また、この研究結果はAIを医師と同じような水準に持ってくるという従来の試みに警鐘を鳴らすという意味でも画期的である。[6]

偏る医療現場と医療テクノロジーの現状

このような医療基準に存在するバイアスは外科分野だけではなく、その他の医療分野でも近年顕著になっている。

例えば、Dr. Kafui DzirasaはNPRのインタビューで、脳科学の分野ではそもそも研究対象として黒人のサンプルデータを考慮していない場合が多いと話し、自身の家族の精神疾患から遺伝と精神疾患の関係性について研究を始めた。

彼は研究を通して初めて、これらの研究サンプルはほとんどがヨーロッパ系統の人口のみを対象にしていることを目の当たりにした。これは遺伝子研究のみならず脳科学全般の傾向であると気づき、African Ancestry Neuroscience Research Initiativeというアフリカ系統のための神経科学の取り組みに関わり始めたと言う。[7]

これは同時に、医療現場に黒人/アフリカ系アメリカ人の人口が少ないという事実とも関わってくる問題である。米国全土における黒人人口が13%なのに対して、医療現場を占める黒人医師は4.1%という低さだ。

この数値の低さは、所得、家族構成、学歴、地域などさまざまな社会的要素と複雑に絡み合っており、非常に重要な問題であることが理解できる。

ヘルステックの未来と医療における人間のこれからの役割とは?

バイアスによる誤作動とは例えば、顔認識システムにおける白人と非白人間における誤認識や、ヘイトスピーチなどを検出する自然言語処理システムアルゴリズム上での黒人と認知された人口の誤検出など。そうしたアルゴリズムの誤作動は、社会に蔓延る偏見をそのまま反映している。[8]

これはアルゴリズムの学習の際に入力するデータの偏りに大きく関係している。オンライン上で展開されるコンテンツの多くにバイアスを含んだものが多く、これらを学習サンプルとして大量に取り込んだアルゴリズムは結果、人間と似たような偏見を持つ情報処理マシンと化する。

入力データの質や多様性、測定基準自体のバランスなどの重要性が今回の研究で証明されたことは、テクノロジーに大きく頼るようになった医療現場に存在するバイアスの改善に貢献できる可能性がある。

このようなデータのバイアスに基づいて、新しいデータの提供の仕方について模索しているヘルステックも出てきた。

以前マイクロソフトのプラットフォーム構築に携わっていたTerry MyersonとLisa Gurryは独立し、直接医療機関から医療データを集め、匿名化し、研究に利用できるようにするTruvetaというスタートアップを設立した。直接医療機関からのデータを集めることでデータセットを大幅に多様化できる可能性があるとして期待されている。[9][10]

人間のミス、医師たちの誤診は、長年社会構造の中に構築された偏見が一因となっている。それを実証することで、今後どのようにデータの中身や計測方法が変化していくのか、注目していきたい。

文:佐藤麦穂

編集:岡徳之(Livit)

参考:

- https://covidtracking.com/race

- https://www.aafp.org/about/policies/all/institutional-racism.html

- https://www.vox.com/22285868/black-white-life-expectancy-gap-covid-19-health

- https://www.nature.com/articles/s41591-020-01192-7

- .https://www.americanbar.org/groups/crsj/publications/human_rights_magazine_home/the-state-of-healthcare-in-the-united-states/racial-disparities-in-health-care/#:~:text=NAM%20found%20that%20%E2%80%9Cracial%20and,physicians%20give%20their%20black%20patients

- https://www.technologyreview.com/2021/01/22/1016577/ai-fairer-healthcare-patient-outcomes/

- https://www.npr.org/sections/health-shots/2020/09/24/915783973/a-neuroscience-project-pushes-to-include-more-african-americans-in-brain-research

- https://www.wired.com/story/why-youtube-chat-chess-flagged-hate-speech/

- https://techcrunch.com/2021/02/20/can-data-fix-healthcare/

- https://truveta.com/blog/creating-truveta-to-save-lives-with-data