AIで障がいを越えていく。Googleアクセシビリティの驚くべき取り組み

INDEX

先日、開発者向けイベント「Google I/O 2019」が開催された。基調講演の冒頭では、Googleのサンダー・ピチャイCEOは「すべての人にとって役立つGoogleを構築していく」という、同社のビジョンを紹介した。

この発言は情報に広くアクセスできるようにし、欲しい答えを得る手助けをするところからさらに歩みを進め、すべての人が知識や成功や健康、そして幸せを得るために役立つGoogleを目指すという、力強い意思表示だ。

基調講演に登壇し、「Building a more helpful Google for everyoneのビジョンを掲げるGoogle CEOのサンダー・ピチャイ氏

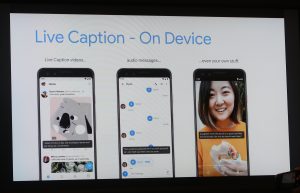

“すべての人”の中には、住んでいる場所も立場も異なる多様な人々、障がいを持つ人々も含まれる。基調講演ではGoogleが今手がけている、AIを用いたアクセシビリティへの取り組みも紹介された。中でも参加者を驚かせたのが、次世代のAndroid OS「Android Q」に実装される、聴覚障がい者向けの機能「Live Caption」だ。

Googleでは、新たな音声および言語の認識モデルを開発。音声認識、言語認識の際に必要なデータ量を、従来の200分の1まで縮小することに成功したという。「Live Caption」はこの新しい認識モデルを活用して、スマートフォンで着信した電話や、ビデオチャット、動画や音声に対し、リアルタイムに字幕を表示できるという。

音声、言語認識でエッジで処理し、リアルタイム自動字幕を実現

これまでもYouTubeの動画に自動で字幕がつけられるしくみはあったが、その処理はクラウドで行われていた。これに対し「Live Caption」は、「オフラインで、しかもアプリを越えて動作するため、Androidで再生できるあらゆる音声をテキスト化できる」と、Androidアクセシビリティのプロダクトマネージャー、ブライアン・ケムラー氏は説明する。

デバイス内でローカルに処理されるため、個人的な動画や音声をどこかへアップロードする必要もない。

「Live Caption」はバックグラウンドで動作し、アプリを問わず音声をテキスト化。字幕を表示できる機能だ

「Live Caption」はバックグラウンドで動作し、アプリを問わず音声をテキスト化。字幕を表示できる機能だ

音声がリアルタイムにテキスト化されるとはどういうことか。いち早く体験したければ、「Live Transcribe」を試してみるといいだろう。Googleは今年2月、「Live Caption」に先駆けて、スマートフォンで音声をほぼリアルタイムにテキスト化する機能「Live Transcribe」を発表している。

現在ベータ版がアプリ(日本語のアプリ名は「音声文字変換」)として提供されていて、すでに日本語にも対応済み。起動して何か話してみればわかるが、その認識精度は驚くほど高い。

Androidアクセシビリティのプロダクトマネージャー、ブライアン・ケムラー氏(右)と、Google AIのプロダクトマネージャー、ジュリー・カッソー氏

ケムラー氏によれば、単語だけでなく前後の文脈を理解してテキスト化しているため、「たとえば『ニュージャージー州(New Jersey)で新しいジャージ(new jersey)を買った』といった内容でも、ニュージャージー州は固有名詞として認識され、新しいジャージの方はちゃんと小文字で表示される」という。「Live Transcribe」は近日アップデートされ、テキスト化された内容のコピーや保存もできるようになる予定だ。

なおGoogleはこのほか、聴覚障がい者向けに音声認識技術とテキストを音声に変換する技術を用いて、電話をかけたり、電話に出たりできるように支援するプロジェクト「Live Relay」に取り組んでいることも、明らかにしている。

スマートフォンがユーザーの目となり、風景を読み上げる

AIを用いたGoogleのアクセシビリティへの取り組みは、もちろん聴覚障がい者に向けたものだけではない。3月にはスマートフォンのカメラによる画像認識機能を用いて、視覚障がい者をサポートするアプリ「Lookout」が、米国の「Pixel」スマートフォンのユーザー向けにリリースされている。

Googleでアクセシビリティ・エンジニアリングのプロダクトマネージャーを務める、パトリック・クラリー氏によれば、このアプリは視覚障がい者が診療所や友人宅、ホテルなど、新しい場所に慣れるのをサポートする。具体的には「どの方向に何が見えるか、人物や服装、さらに米国の通貨なども認識し、音声で読み上げることができる」という。

このほか「Google I/O 2019」では、脳卒中やALS、パーキンソン病、多発性硬化症などによって言葉の発生が困難な人々の話し方をAIに学習させ、彼らのコミュニケーションをサポートする「Project Euphonia」や、言葉を発せない障がい者がボタン型の装置を使って「Google Home」を利用できるようにする「Project Diva」も紹介された。

「Project Euphonia」では、米国の非営利団体の協力を得て「ALS患者の音声サンプルを収集している」とGoogle AIのプロダクトマネージャー、ジュリー・カッソー氏。また「Project Diva」は、ミラノ在住のGoogleのエンジニア、ロレンツォ・カッジョーニ氏が、ダウン症など複数の障がいを持ち、言葉を発するのが困難な弟のために開発したものだ。注目すべきは、いずれのプロジェクトでも障がいを持つ当事者が、開発に深く関わっているということだ。

「Project Diva」を立ち上げた、戦略的クラウドエンジニアリング担当エンジニアのロレンツォ・カッジョーニ氏(右)。目の前には「Google Home」を操作できるボタン型デバイスが並ぶ。

「Project Diva」を立ち上げた、戦略的クラウドエンジニアリング担当エンジニアのロレンツォ・カッジョーニ氏(右)。目の前には「Google Home」を操作できるボタン型デバイスが並ぶ。

アクセシビリティへの取り組みは、障がい者のためだけにあらず

自身も脊椎損傷による障がいを持つパトリック・クラリー氏は、「開発にあたっては、実際にアクセシビリティのニーズを持つ、たくさんの人々の協力を得ている」と明かす。「様々なコミュニティに参加して、当事者と一緒にテストを行う中で、我々のプロジェクトの持つ影響力の大きさを再確認している」という。

アクセシビリティ・エンジニアリングのプロダクトマネージャー、パトリック・クラリー氏。胸から下げている「Pixel 3」には「Lookout」が搭載されていて、カメラで捉えた風景を読み上げることができる。

一方で「アクセシビリティに取り組むことは、単に障がい者を助けるだけにとどまらない」とクラリー氏。「たとえば車椅子で移動しやすい道に改装すれば、ベビーカーを押している人やスーツケースを引いている人もその恩恵を受けられる。最初は障がいのある人のために開発されたテクノロジーが、結果として多くの人にメリットをもたらすことがある」と語った。

実際に「Live Caption」のような機能は聴覚障がい者を助けるだけでなく、図書館や電車の中など音を出しづらいシチュエーションで、多くの人の役に立つだろう。Googleのアクセシビリティへの取り組みはその意味でも、「すべての人にとって役立つGoogle」へとつながっているのだ。

取材・文:太田百合子