テキストで検索って手間じゃない?僕らは“画像”で検索する時代に向かう

何か知りたい情報があれば、文字を入力して検索をする——2010年頃までは、それが当たり前とされていた。そんな検索スタイルに変化が生じ始めたのは2011年、iPhoneに音声アシスタント機能「Siri」が搭載されたことが契機だろう。

以降、音声アシスタントに話しかけて、知りたい情報を得る。今やすっかり、音声による検索スタイルは当たり前となった。

2017年に開催されたGoogleの開発者向けカンファレンス「Google I/O」にて、「Googleモバイル検索のクエリのうち20%が、音声検索になっている」旨の発表があったと、ジェフ・ジャービス氏が語っている。

このまま音声での検索行動が増えていくことも考えられる一方で、音声以外にも注目を集める検索方法が登場してきている。

ビジュアル検索機能「Google Lens」が登場

Googleは「Google I/O」で、AIを活用したビジュアル検索機能「Google Lens」を発表した。この機能は、Googleのコンピューターに取り入れた生の画像情報を処理し、必要な情報を取り出す技術「コンピュータビジョン」と「人工知能」を統合したシステムだ。スマートフォンのカメラで映し出した映像内にある物体を認識し、それが何か、またはその物体に関する情報を検索して、AR表示などでユーザーに教える。

例えば、道ばたに咲いている花や街中にある飲食店をカメラで映したとしよう。Google Lensはリアルタイムに物体を認識し、花の種類や飲食店情報、人気度を教えてくれる。また、Wi-Fi設定が書かれたカードをカメラで読み取れば、その情報を解釈し、自動でスマートフォンをWi-Fiに接続してくれる。

フリック入力をする必要はなく、カメラをかざすだけで知りたい情報が得られる。そんな時代がやってきたのだ。

海外では活発になりつつある、「画像検索」強化の動き

こうした、ビジュアル検索に関する動きは、何もGoogleに限った話ではない。海外企業を中心に、ここ数年でビジュアル検索機能を強化する動きが活発になってきている。

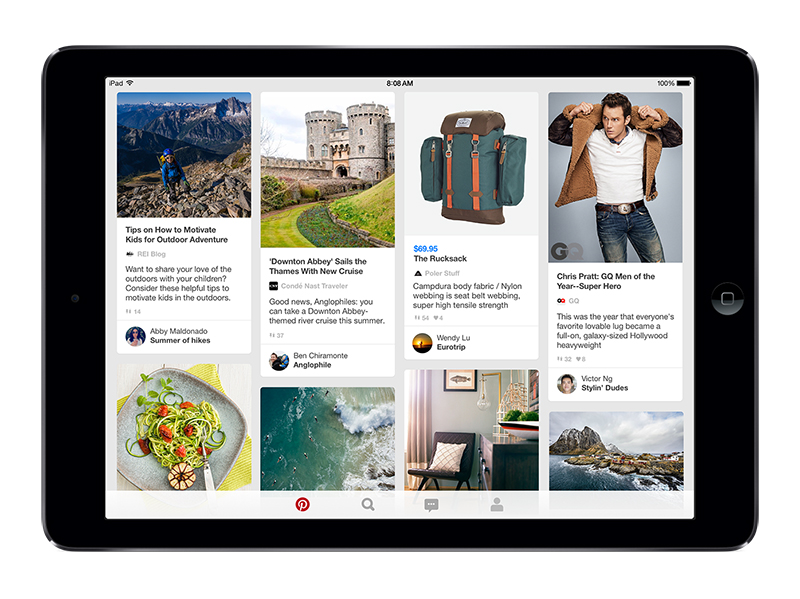

例えば、気に入った画像を「ボード」へ貼りつけて、共有できるウェブサービス「Pinterest(ピンタレスト)」は、スマートフォンのカメラで撮影したものに関する情報や、それに関係のある「ピン」を表示してくれる画像検索機能「Lens」を2017年2月に発表した。

このLensも仕組みは、Google Lensと同じだ。アプリを使って撮影した写真を機械学習で解析し、関連のある画像を表示してくれる。家具や食器を撮影した場合、デザインの似たものが表示される以外に、被写体に関連したさまざまなデザインのアイテムが提案される。また、食べ物を撮影するとレシピも表示される。

さらには、Facebookは開発者向けカンファレンス「F8」で、頭に思い浮かべるだけで文章が書ける、入力技術の研究開発を進めていることを発表している。

パソコンのデスクトップに表示された検索窓に文字を入力する時代から、スマートフォンの登場によって、検索のスタイルは変化。音声、ビジュアルによる検索が当たり前になろうとしている。文字入力による検索で一時代を築いたGoogleはいま、新たなデファクトスタンダードとなる検索の形を模索しているのだろうか。