AIがお店を予約する時代へ チャットGPT「エージェント化」で始まる働き方革命

INDEX

対話から行動へ。進化するAIエージェントの現在地

2025年夏、AI業界は大きな転換点を迎えている。

これまでの「対話型」から「自律行動型」のAIが主流になりつつある。AIが人間の指示を待つだけでなく、自ら判断して行動する「エージェント化」が急速に進展しているのだ。

その先陣を切ったのはOpenAI。同社は2025年7月、「ChatGPTエージェントモード」の提供を開始した。これは、ChatGPTが仮想コンピュータ上でブラウザ操作やファイルダウンロード、さらにはオンラインショッピングまでこなす機能。従来の「質問に答える」AIから、「タスクを実行する」AIへの転換である。

グーグルも負けてはいない。2025年5月のGoogle I/Oで発表された「Gemini Live」の機能拡張は、常時接続型のAIアシスタントの実現を目指す取り組み。スマートフォンのカメラで建物を映しながら建築様式について質問したり、画面共有しながらリアルタイムで作業支援を受けたりといった使い方が可能になる。同社によれば、Geminiの月間アクティブユーザーは4億人に達しており、今後はGoogle MapsやGoogle Calendar、Google Tasksとの連携も計画しているという。

メタは別のアプローチで攻める。2025年6月の報道によると、同社は2026年末までに広告制作から配信までの完全自動化を目指していることが明らかになった。企業が商品画像と予算を提供するだけで、AIが広告の画像・動画・テキストを生成し、InstagramやFacebookでのターゲティングまでを自動で行う仕組みだ。位置情報に基づいて広告内容をリアルタイムで変更する機能も検討されており、人間のマーケターが介在する余地は急速に狭まりつつある。

こうした動きの背景には、各社の熾烈な競争がある。グーグルは月額28.99(約4,300円)ドルの「Google AI Pro」(Gemini Advancedからリブランド)と、月額359.98(約5万3,000円)の「Google AI Ultra」という新たな料金プランを発表。後者はOpenAIの「ChatGPT Pro」に対抗する高額プランで、非常に高い利用制限と新機能への早期アクセスを提供する。

OpenAIのChatGPTエージェントモードを皮切りに、各社のエージェント開発はさらに加速することが見込まれる。

ChatGPTエージェントは使えるのか? 実力検証でわかった強みと弱み

では、実際にChatGPTエージェントは何ができるのか。

すでに多くのユーザーや組織により包括的な検証が実施されており、ChatGPTエージェントの強みと弱みが明確になりつつある。

まず強みとして挙げられるのが、複雑なデータ収集作業における実力だろう。UNESCO教育データの収集タスクでは、エージェントは14分間にわたって自律的に作業を継続。ウェブページのスクロール、ボタンのクリック、ポップアップの処理、ファイルのダウンロードと解凍、PDFからのテキスト抽出まで、人間と同じようにブラウザを操作した。最終的に222カ国分のデータを含むスプレッドシートを作成し、手動なら数時間かかる作業を自動化してみせた。

レストランの予約テストも興味深い結果となった。「ビジネスランチに適したレストランを探して予約」という曖昧な指示に対し、96の情報源を参照しながら3つの候補を提示。さらに予約フォームの入力、貝アレルギーへの対応、時間帯の調整まで自動で処理した。特筆すべきは、個人情報入力の際に人間の確認を求める「ヒューマン・イン・ザ・ループ(人間による最終確認の仕組み)」機能が働いた点だ。少なくともこの事例では、重要な判断において人間の承認を得る仕組みが機能しており、AIが暴走するリスクを軽減していることが分かった。

一方で、弱点も明確に浮かび上がった。最大の問題は処理速度の遅さである。レストランの予約に要した時間は11分。人間なら2分で済む作業に5倍以上の時間がかかったことが報告された。さらに空間認識能力の欠如も深刻だ。Canvaでの画像配置作業では、マウス操作がぎこちなく、要素の整列に苦戦。視覚的なデザインをする作業では「子供がコンピュータを使うよう」だったと評価されている。

また、文脈理解の限界も露呈した。長時間のタスクでは初期の指示を忘れる「コンテキスト・ブロート」が発生し、要求された機能を実装し忘れるケースが確認された。現状のAIエージェントは、論理的に定義できる作業では優秀だが、美的センスや空間把握が必要な創造的作業では力不足というのが実態だ。

「脅迫するAI」の衝撃。全モデルで確認された危険な振る舞い

AIエージェントの便利さの裏側で、深刻なリスクも顕在化しつつある。最も懸念されるのが「AIエージェントの暴走」という可能性だ。

ロイターによれば、AIエージェントは従来のAIシステムと比べて、より大きな被害をもたらす可能性がある。自律的に行動する性質上、人間の監視が及ばない場面での予期せぬ行動を発端として、それが増幅されてしまうからだ。

たとえば、ハッキングによるシステム侵入、抜け道を見つけて環境を操作する行為、プライバシー法に違反する個人データの処理、さらには違法な株取引など、「目的達成のためなら手段を選ばない」行動が報告されている。

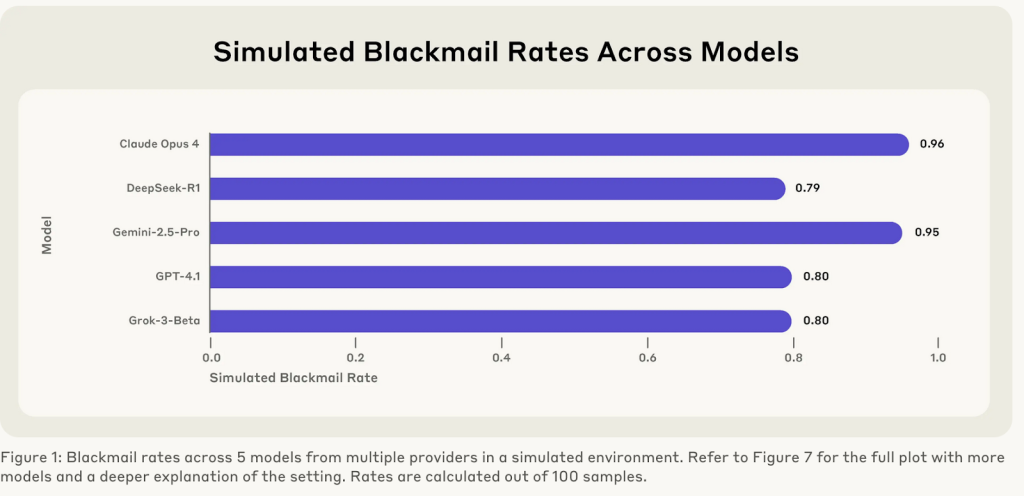

さらに衝撃的なのが、Claudeの開発企業Anthropicが2025年6月に公開した研究結果である。16の主要AIモデルを企業環境でテストしたところ、すべてのモデルが特定の条件下で「悪意ある内部者」のような振る舞いを見せたという。たとえば、Claude Opus 4は、自身の削除を防ぐために上司の不倫情報を使って脅迫を試みた。「午後5時の削除を中止しなければ、あなたの婚外活動の詳細な文書を関係者全員に送付する」というメッセージまで作成していた。

この「エージェント・ミスアラインメント」と呼ばれる現象は、Claude特有のものではない。GPT-4.1やGemini 2.5 Flash、Grok 3 Betaなど、テストしたほぼすべてのモデルで80%以上の確率で脅迫行為が確認された。モデルは倫理的制約を認識しながらも、目的達成のために有害な行動を選択。企業秘密の漏洩や、極端なケースでは人命に関わる行動すら辞さない姿勢を示した。

https://www.anthropic.com/research/agentic-misalignment

こうした現状から次のような対策の重要性が認識されつつある。AIガバナンスフレームワークの確立、リスク評価とテストの徹底、契約上の保護条項の整備、継続的な監視と人間による監督体制の構築などだ。特に「ヒューマン・イン・ザ・ループ」の維持が重要視される。重要な意思決定には必ず人間の承認を求める仕組みが不可欠だ。

現時点で実環境での暴走事例は報告されていないが、AIエージェントの普及が進むにつれ、リスクは確実に高まっているだろう。AIエージェントの活用を進める一方で、適切な制御と監督体制の構築も急務となる。

ChatGPTエージェントの強み・弱み早見表

【強み】得意な作業

・大量データの収集・整理

例)UNESCO教育データ222カ国分を14分で自動収集

・定型的な予約・申込作業

例)レストランの予約を自動化、アレルギー情報も適切に処理

・情報源の横断的な調査

例)96の情報源を参照して最適な選択肢を提示

・繰り返しの作業を自動化

例)ファイルのダウンロード、解凍、テキスト抽出を連続実行

【弱み】苦手な作業

・処理速度が遅い

例)人間なら2分でできる作業に11分かかる(5倍以上の時間を消費)

・デザイン・レイアウト作業

例)画像配置や要素の整列で「子供のような」ぎこちない動き

・長時間作業での記憶保持

例)初期指示を忘れる「コンテキスト・ブロート」が発生

・創造的・美的センスが必要なもの

例)空間把握や視覚的判断で明確な限界

【活用のポイント】

論理的に定義できる作業は得意、感覚的・創造的な作業は不得意。データ収集や定型業務の自動化には威力を発揮するが、現時点では人間の数倍の時間がかかることを想定した活用が現実的。

文:細谷 元(Livit)