自動運転車の開発が本格化している。トヨタは2020年の東京オリンピックで“お披露目”すると発表、ホンダはグーグル傘下のIT企業ウェイモと提携し、2025年までにはレベル4(システムによる主導運転)の自動運転車を開発すると名言している。

ドライバー不在でも、私たちの望む場所へ運んで行ってくれる夢のような車。以前なら、ドラえもんのポケットからしか出てきそうになかったようなシロモノの実現が目前に迫っている。

しかし、もしこの「夢の車」が殺人機になる可能性があるならば…あなたはどうするだろう。購入するか、それとも買い控えるか。そして、車が起こした殺人は誰の責任になる?

2014年、自動運転車の「倫理観」を問う興味深い実験が行なわれた。もし誰かを犠牲にしなければならない場合、自動運転車はどのような選択をすべきか。いわゆる「トロッコ問題」である。

「Aを犠牲にしてBを救う」トロッコ問題とは?

「トロッコ問題」とは、次のことを指す。線路の向こうから暴走するトロッコが走って来る。このままでは線路上にいる5人の人間を轢いてしまう。自分は線路を方向転換できるレバーを持っているが、レバーを引いたらもう一方の線路上の1人を犠牲にしてしまう。レバーを引くべきか、そのまま何もしないか――。究極の選択下における、人間の道徳観・倫理感を問う問題である。

2014年、マサチューセッツ工科大学のコンピュータ科学学者、イヤード・ラフワン氏をはじめとする研究チームは「モラル・マシン(Moral Machine)」というクイズ式の実験を考案した。回答者は「Aを犠牲にしなければBが助からない」誰かの死を避けられない状況で、自動運転車はどちらの犠牲を選ぶのかを選択する。実験では、若者、年寄り、金持ち、ペットなどの様々なタイプの“犠牲者”を用意し、さらに人数の多少などを組み込んだ、13の異なるシナリオを用意した。

モラル・マシンをクラウドソージングで拡散したところ、思いの他反響が大きく、発表1年半で世界233ヵ国、約4,000万人からの回答を得られた。それによると、非常に興味深い結果が浮かび上がったという。国や地域、その国の発展の度合いなどにより、人々の選択が大きく異なるというのだ。

地域や国の状況により異なる価値観

まず、ペット(動物)よりも人間を保護するということに関しては、年齢、性別、国や地域を問わず共通していた。しかし、そこからは細分化する。

それによると、大まかに3つのグループに分けられるという。まず、北米やヨーロッパ諸国を含むキリスト教が支配的である国。次に、日本やインドネシアなど、儒教やイスラム教の強い国。最後に、中南米など旧フランス植民地の国。1番目の国々は、2番目よりも高齢者より若者を救うことを選ぶ傾向があったという。

さらにコロンビアなど貧富の差の大きい国の人は、より低い地位の人を犠牲にすることを選び、強力な法治国家である日本やフィンランドは “違法”に道路を横切る人に対して冷たい措置をとる選択をしたという。

この実験からわかることは、国の歴史的・宗教的背景や、経済的、構造的な要因が人々の倫理感に深く絡んでいるということだ。人間ですら難しい道徳的判断を、機械である自動運転車にどこまで求めることができるのだろう?しかも“正解”が場所や判断する人により異なるという、複雑怪奇なシチュエーションで。

AIに倫理観を植えつけることは可能か

言わずもがな、自動運転車の“ドライバー“はAIだ。AIは、通常人間の脳が行っている、判断、記憶、学習、推測といったことを人工的に行ってくれるシステムだ。

AIはこれまで、膨大なデータの蓄積や人間の指示により動いていたが、現在は「ディープラーニング」という、判断まで自ら学習する能力が開発されている。今後、AIは道徳観を含んだ判断すら「学習」をすることができるのか?

AIは医療用ロボット、軍事用無人機など、人命に関わるものにも搭載されている。英国のロボット倫理学者アラン・ワインフィールド氏による、ロボットを使った実験で興味深いものがある。

実験は、穴に落ちている2体のロボット(H)を、別の1体のロボット(A)に救わせるというものだ。Aには周囲物に対する位置を感知する能力が備えられ、意図的に相対物を傷つけはしないが、その限りでもないというようにプログラムされている。実験によると、Aは穴に少しずつ近づき、Hを助けようとさえした。しかしそれを何度か繰り返すうちにAのシステムはショートしてしまい、ついにAは2体のHを見殺しにしたのだ。

この問題を解決するためには、どうプログラムしたらよいのか?Aは自らの身を滅ぼして、Hを救う選択をすべきなのか?もしくは保身というAの選択が正しかったのだろうか?もしこれが軍用機であれば、常にこのような緊迫した選択にさらされるだろう。AIと倫理観に横たわる問題は、あまりに大きい。

自動運転車解禁まであと2年。問題解決に「待ったなし」

さて、話を自動運転車に戻そう。この「トロッコ問題」に対して自動車メーカーは、どのような反応を示しているだろう。アウディのバーバラ・ウェージ氏は、冒頭のMITの実験を「価値がある」とした。そして「自動運転車が事故を起こす確率は従来よりも低くなるだろう。しかし、ロボットが関わる出来事には、より注意を払う必要がある」と述べている。ボルボは「当社開発の自動運転車に対して、すべての責任を担う」と公約した。

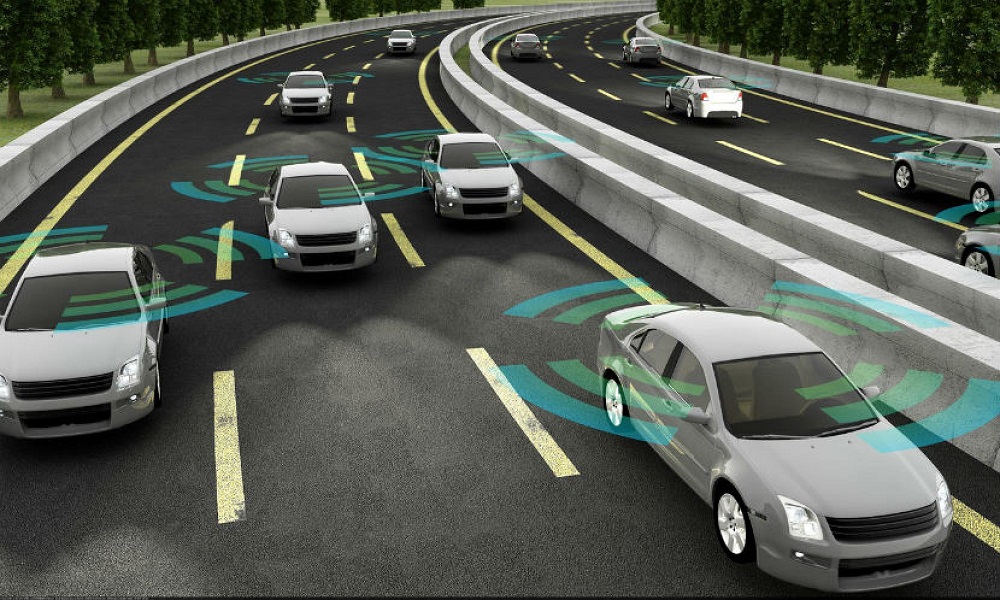

日本の状況はどうだろうか?なお、自動運転車には6つのレベルがある。このうち、ドライバーが不用になり、完全にAIが運転を担うのはレベル4以上だ。刻々と変わる景色の中、人や標識、道路、周囲の店、街路樹など、様々なものを一瞬で識別・判断し、それらに対して適切な反応をしなければならないという、非常に高度な知能と情報処理能力が必要とされる。日本政府は、国土交通省が2018年9月策定した「自動運転車の安全技術ガイドライン」において、2020年までにレベル4の自動運転車を、地域を限定して部分的に導入することを目指している。そして2025年を目途に、レベル4車が高速道路で走行できるようにすると目標を定めている。

倫理的問題についての答えはいまだに出ていない。しかし、自動運転車の市場化は目前だ。飲酒運転やドライバーの不注意による事故など、これまで人間が起こしてきた人為的な事故は減るだろう。自動運転車の参入は、相対的に見ればプラス面が勝っているかもしれない。しかし、実際に市場化されから、これまで予期しなかった課題も多々出てくることは間違いない。今のうちにどれだけ予測・回避できるか。車社会を生きる私たち全体で考えなければならない問題なのかもしれない。

文:矢羽野晶子

編集:岡徳之(Livit)